ML - skattning

Tjenare på er!

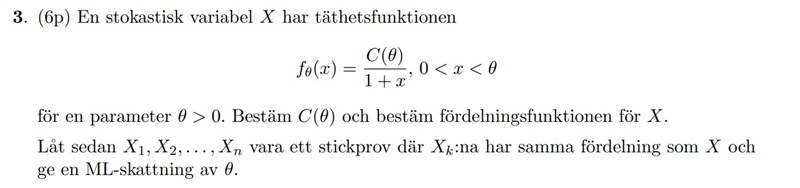

Håller på med följande gamla tentauppgift:

Jag har lite bekymmer med att lösa uppgiften, men jag tänker att jag presenterar den först så tar jag upp vart det stannar för mig i min lösning allt eftersom.

Vi bildar likelihood-funktionen som följer:

Observera att

Därför fås:

För att hitta en ML - skattning av , vill vi maximera likelihood-funktionen, vilket är detsamma som att maximera log-likelihood-funktionen:

Vi ser dock ganska fort att om vi deriverar denna map , så är likelihoodfunktionen en strikt avtagande funktion map .

För att maximera likelihoodfunktionen, och därav hitta ML - skattningen för vår parameter, vill vi ta ett så litet , som möjligt. Därför tänker jag att man väljer .

Men svaret verkar istället vara att man ska välja maximumet från stickprovet. Jag förstår inte riktigt logiken hur detta fungerar när man får en likelihood som är strikt avtagande / växande och därur ska motivera för hur man ska välja en ML - skattning för sin parameter. Skulle vara extremt tacksamt om någon skulle kunna förtydliga detta för mig.

Tack!!

Problemet börjar egentligen med en otydlighet vad gäller likelihood-funktionen.

För en observation x får vi mer precis:

Likelihood-funktionen för hela stickprovet blir därför 0 om är mindre än något . Så likelihood-funktionen är nollskild endast om

för alla i, dvs .

Då förstår jag! Det är alltså "gränserna" som är viktiga att tänka på. Tack så hemskt mycket. Har dock ytterligare en fråga:

Vad vill vi få ut ur en ML - skattning? Varför gör vi denna? Är det ett alternativt sätt att hitta en uppskattning på en okänd parameter, och är den i så fall en bra sådan uppskattning?

johannes121 skrev:Är det ett alternativt sätt att hitta en uppskattning på en okänd parameter,

Ja

och är den i så fall en bra sådan uppskattning?

Ja, ofta får de skattningarna låg varians.

Micimacko skrev:johannes121 skrev:Är det ett alternativt sätt att hitta en uppskattning på en okänd parameter,

Ja

och är den i så fall en bra sådan uppskattning?

Ja, ofta får de skattningarna låg varians.

Jag skulle vilja förtydliga här lite. För det första är ML-skattning inte en alternativ metod, utan standardmetoden.

Om det är en bra metod beror mycket på vilken fördelning man skattar från. Det beror också på syftet med skattningen, om man vill beskriva eller prediktera. ML-skattningen används främst i deskriptiva sammanhang,

Mickimacko skriver att skattningarna ofta har låg varians, vad som är låg varians kan väl diskuteras men jag skulle hävda att Mickimacko har fel, när man använder någon annan metod än ML-metoden beror det oftast på att ML-skattningen har för hög varians.

Jag skulle kunna skriva väldigt mycket om det här, det är bara att säga till så kan jag utveckla.

Tack till båda er. Intressant! Undrar samtidigt hur metoden fungerar egentligen. Jag förstår själva proceduren för hur man hittar en ML skattning, men varför ser den ut som den gör?

Jag skulle säga såhär: likelihood ger ett mått på ”hur troligt är det att datan är genererad från fördelningen med detta värdet på parametern?”. Så det man gör är att man helt enkelt maximerar denna funktion, och hittar då den parameter som det är mest troligt att datan är genererad från