Rang och spår för "engångsmatriser"

Engångsgrillar och andra engångsartiklar håller (med all rätt) på att sluta säljas eftersom de anses vara alltför miljöovänliga. Lyckligtvis gäller detta inte för "engångsmatriser", som dyker upp överallt i matematiken (fast under seriösare namn) och som vi kan definera på följande sätt:

Definition. En engångsmatris är en matris som uppfyller likheten , dvs. det är en matris som det bara är lönt att använda en gång!

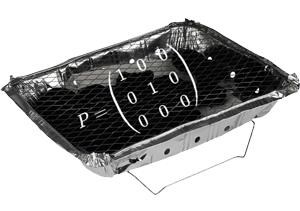

Ett exempel på en engångsmatris är

som projicerar ner på xy-planet. Försöker man appliera en mer än en gång händer inget nytt, utan .

Vi gör nu ett påstående om engångsmatriser. Kluringen består i att avgöra om påståendet är sant eller falskt, och att motivera varför (antingen genom att ge ett bevis eller genom att konstruera ett motexempel).

Påstående. För varje engångsmatris gäller det att rangen är lika med spåret, dvs. att .

Nivå: Linjär algebra eller matristeori motsvarande (åtminstone) en första grundkurs på universitetsnivå.

Jag tror att påståendet är fel eftersom

Red.: Jag glömde att det handlar om engångsmatriser. För generella matriser tror jag att påståendet är fel.

Låt v vara en godtycklig vektor i rummet . Då ska det alltså gälla att

eller ekvivalent med . Det senare är intressant eftersom detta betyder att antingen så är dvs att v är en egenvektor med egenvärde 1, eller så är en egenvektor till Amed egenvärde 0.

Detta antyder en induktiv process liknande Gram-Smidt i vilket vi kan separera ut alla egenvektorer till A och se att de antingen har egenvärde 1 eller 0.

0. Definiera två mängder M och N, där M kommer vara en mängd innehållandes egenvektorer med egenvärde 1 och N vara en mängd som innehåller egenvektorer med egenvärde 0.

1. Ta en vektor v ur V. Om v är en egenvektor med egenvärde 1 så lägg den i M och tag det ortogonala komplementet av alla vektorer i V till v, dvs ta bort alla vektorers komponenter som är parallella med v. Vi uppdaterar V <- V_{v}

Om v inte är en egenvektor med egenvärde 0 så lägg (A - I)v i mängden N och projicera bort den vektorn från V.

2. Upprepa steg 1, där varje upprepning reducerar V:s dimension med 1, tills dess att V har reducerats till dimension 0.

3. Eftersom processen tog n steg så har vi funnit s egenvektorer med egenvärde 1 och t egenvektorer med egenvärde 0, där s + t = n.

(En möjlig invändning är att (A - I)v kanske inte är är oberoende av en vektor som redan placerats i M eller N och i skrivande stund kan jag inte utesluta det. Jag känner mig dock dugligt säker på saken men välkomnar ett motbevis)

Nu har vi funnit att matrisen har s egenvektorer med egenvärde 1 och t egenvektorer med egenvärde 0.

Spåret av men matris är summan av dess egenvärden vilket blir tr(A) = s och rangen av en (diagonaliserbar) matris är antalet egenvärden som inte har 0 som egenvärde vilket också är s, rang(A) = s.

Alltså

tr(A) = rang(A)

(Notera att vi faktiskt kan behöva använda matrisen (eg. A - I) upp till n-1 gånger för att få ut egenvektorerna så så en enda gång räcker inte)

Jag förstår inte din algoritm. Vad händer i steg 1 om vi inte tar en vekter med egenvärde 1? Om vi tar en med egenvärde 1, varför finns det egenvektorer i ortogonala komplementet?

Stycke två i steg 1 borde säga att om v inte är en egenvektor med egenvärde 1 (står 0) så är (A-I)v en egenvektor med egenvärde 0.

Argumentet har som sagt en outforskad del gällande oberoendet mellan egenvektorerna man plockar ut och har önnu inte fixat det hela.

Kruxet ligger egentligen i att det för mitt inte öga är uppenbart att sådana matriser är diagonaliserbar i vilket fall satsen faller ut naturligt men utan att se att sådana säg är symmetriska eller i någon diagonaliserbar klass så blir algoritmen är ett försök att komma fram till att den är diagonaliserbar.

Du kan ta en genväg genom att matrisen (eller en normal operator) är diagonaliserbar om den algebraiska multipliciteten är lika med den geometriska multipliciteten. Dimensionen för värderummet, V(P), och dimensionssatsen garanterar att n-rang(A) är antalet "nollrader" och en reell idempotent matris är alltså alltid diagonaliserbar.

Hur bestämmer du multipliciteterna isf i detta fall?

SeriousCephalopod skrev:Hur bestämmer du multipliciteterna isf i detta fall?

Eftersom den karaktäristiska ekvationen är av grad n om A är en nxn-matris, så har enligt algebrans fundamentalsats A exakt n egenvärden, om man räknar med (algebraisk) multiplicitet. Vi låter dimensionen av värderummet till A vara .

Låt oss anta att (n-r) st av dessa egenvärden antar värdet 0. Egenvektorer hörande till dessa egenvärden ligger naturligtvis i N(A), ty . Resterande egenvektorer, dvs r stycken, måste då ligga i V(A), ty och enligt dimenssionssatsen.

Förövrigt "brukar" man använda egenskaper hos minimalpolynomet för att visa att en idempotent matris är diagonaliserbar (med egenvärden 0, 1).

Men man kan också gå "direkt", om för något egenvärde den geometriska multipliciteten är strikt mindre än den algebraiska kan inte summan av egenrummens dimensioner vara lika med det karakteristiska polynomets gradtal. Om vi delar upp rummet som en direkt summa (se V ovan) följer därför att varje egenvärdes geometriska multiplicitet är lika med dess algebraiska. (jmfr spektralsatsen för normala operatorer).

--------------------------------------------------------------------------------------------------------------

Slutligen kan man kan använda determinanter också! Om determinanten utvecklas ser vi att

Vi inser också att

Ur vilken vi bland annat kan identifiera

Där vi använt beteckningen Tr(A) för summan av A:s diagonalelement (spåret)

I vårt fall är summan och därför måste

Kul med all respons! Jag avvaktar tills i morgon med mitt eget förslag, men ger två kommentarer så länge.

@Albiki: Att konstatera att påståendet är orimligt för generella -matriser är definitivt en bra början (och kanske något jag borde ha påpekat redan i trådstarten för att få påståendet att kännas mer spektakulärt).

Nu när jag tänker efter lite mer är det ju verkligen helt absurt att det för generella matriser skulle gälla att . Vänsterledet är ju ett heltal mellan och , medan i allmänhet inte ens är ett heltal.

Så om påståendet gäller för engångsmatriser, så måste det vara något med egenskapen som rejält begränsar vad kan vara. Och en sådan insikt kan definitivt vara en bra ingång, både för att leta motexempel eller som inspiration för ett bevis.

@Guggle: Jag måste säga att det är lite svårt att följa dina resonemang. I princip håller jag med om det du skriver, men det är många omotiverade påståenden och infallsvinklar på en gång. Funderar främst på följande punkter:

- I ditt första inlägg konstaterar du att nollrummet för en matris har dimensionen $$n-\mathrm{rang}(A). Hur menar du att det medför att engångsmatriser är diagonaliserbara?

- Du påstår även att är en direkt summa av värderummet och nollrummet, men jag tycker inte det framgår varför det skulle vara sant.

- I ditt andra inlägg konstaterar du att har stycken (komplexa) egenvärden, räknade med algebraisk multiplicitet, och du skriver sedan att du antar att av dessa egenvärden är 0 (där är rangen för ). Men för att ditt argument ska fungera måste du väl visa att detta verkligen är sant?

- I ditt tredje inlägg härleder den klassiska, trevliga likheten . Men hur vet du att summan av egenvärdena i sin tur är lika med rangen?

- Du nämner även normala operatorer och spektralsatsen på ett par ställen. Vad är kopplingen mellan detta och engångsmatriser?

Använd rankfaktorisering. En matris A med rank R kan skrivas som en produkt av två matriser, P och Q där P har full rank i kolonnrummet och Q har full rank i radrummet. Från detta följer att P har en vänsterinvers och Q har en högerinvers och att där I är identiteten som är en R x R . Vi kan då skriva att

där vi använder oss av inverserna från vänster och höger. Från detta ser vi då att

där vi använt oss av att .

(Sorry att jag inte latexade allt, jag tål inte att göra det för mycket på windowsdatorer)

@Guggle: Jag måste säga att det är lite svårt att följa dina resonemang. I princip håller jag med om det du skriver, men det är många omotiverade påståenden och infallsvinklar på en gång. Funderar främst på följande punkter:

Oj, då har jag misslyckats i min pedagogiska gärning!. Nu var mina inlägg iofs inte avsedda som formella bevis utan som tips om hur man kan gå till väga, men jag förutsätter du håller med om följande resultat från linjär algebra:

- En självadjungerad operators egenvärden är reella. (Och en unitär operators egenvärden är komplexa tal med absolutbelopp 1).

- En godtycklig operators olika egenrum är linjärt oberoende.

- Egenrummen för normala operatorer är parvis ortogonala och kan alltså uttryckas som en summa.

Nu tycker jag att SeriousCephalopod på ett framgångsrikt sätt redan visat att egenvärden till en idempotent matris antingen är 0 eller 1, men låt utgöra en linjärt oberoende bas till värderummet V(A). Låt vara r st vektorer i värderummet för vilka

Multiplicera med A och utnyttja

Basen är alltså r stycken linjärt oberoende egenvektorer till A med egenvärdet 1 som spänner V(A).

Den geometriska och algebraiska multipliciteten för egenvärdet 1 är det samma som dimensionen för värderummet V(A).

Summan av egenvärden (de andra n-r är ju 0)

Eftersom gäller alltså . Är du med på det?

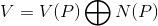

Baserat på punkterna ovan kan man också visa att om A verkar på det n-dimensionella rummet V så är

.jpg?width=800&upscale=false)

Och den idempotenta operatorn A är diagonaliserbar, naturligtvis gäller dimensionssatsen med dim V(A) = r att dim N(A) = n-r (egenskaper vi inte behöver men som kan hjälpa den som faktiskt vill diagonalisera A).

@Guggle: Tack för förtydligandet! Dock är jag fortfarande förvirrad över hur självadjugerade/normala operatorer och spektralsatsen kommer in i bilden?

oggih skrev:@Guggle: Tack för förtydligandet! Dock är jag fortfarande förvirrad över hur självadjugerade/normala operatorer och spektralsatsen kommer in i bilden?

Jag ska kanske vara lite mer tydlig med vad som är tips och ledtrådar i framtiden. Som jag visat behöver man inte diagonalisera A för att visa . Och man behöver inte använda normala operatorer eller spektralsatsen för att visa det.

Det jag försökte ge tips om var två andra möjliga sätt att visa att V kan skrivas som en direkt summa av N(A) och V(A) där dimensionen av V(A) = r och dim N(A) = n-r; 1) minimalpolynomet (vad delar vad?) eller 2) skriva om A på ett lämpligt sätt samt utnyttja spektralsatsen (en ledtråd här kan vara att börja med att studera om det finns en unitär operator U så att ).

Jag hänger med på hur normala operatorer kommer in i bilden, det som jag som sagt inte hänger med på är vad beviset är för att operatorn är normal (även om jag såklart vet att så är fallet).

För mina ögon dyker faktumet att matrisen är normal/diagonaliserbar plötsligen bara upp efter att Guggle kommenterat på multipliciteterna men utan att det görs en konkret hänvisning till egenskapen som nu endast använd för att visa att egenvärdena är 0 eller 1.

Kruxet ligger som sagt i att vi endast vet att geometriska multpliciteten är mindre än den algebraiska men inte, utifrån texten, att de är lika.

Tag följande matris som vare sig är självadjungerande eller normal men som har egenvärden 0 eller 1 som ett exempel på vad som skulle kunna hända om multipliciteterna inte var lika.

Här gäller alltså att karaktäristiska polynomet är där det för 1-egenvärdet gäller att algebraiska multipliciteten är 2 och att geometriska multipliciteten är 2 men för 0-egenvärdet så är algebraiska multiplicteten 2** och geometriska multipliciteten 1 så vi får spår = 2 och rang = 3.

Från detta exempel kan vi generalisera oss till "Om en generell matris har egenvärden 0 eller 1 så gäller " men inte likheten.

Så hur motiverar vi, utifrån att , att geometriska multipliciteten för 0-egenvärdet är lika med den algebraiska multipliciteten för 0-egenvärdet?**

EDIT: På **-ställena är det möjigt att min användning av geometrisk multiplicitets-begreppet inte är 100 korrekt då jag är ovan med att använda det men förhoppningsvis framgår fokuset ändå.

emmynoether skrev:Använd rankfaktorisering. En matris A med rank R kan skrivas som en produkt av två matriser, P och Q där P har full rank i kolonnrummet och Q har full rank i radrummet. Från detta följer att P har en vänsterinvers och Q har en högerinvers och att där I är identiteten som är en R x R . Vi kan då skriva att

där vi använder oss av inverserna från vänster och höger. Från detta ser vi då att

där vi använt oss av att .

(Sorry att jag inte latexade allt, jag tål inte att göra det för mycket på windowsdatorer)

Jag blir besviken på de andra deltagarna i tråden när de helt ignorerar ditt inlägg EmmyNoether.

Ditt inlägg är helt klart den mest eleganta lösningen på problemet; kort och koncist, utan en massa svada om egenvärden, geometriska multipliciteter, algebraiska multipliciteter, självadjungerade normala operatorer, karakteristika polynom och jag vet inte vad. Det finns lösningar och så finns det lösningar.

Albiki skrev:emmynoether skrev:Använd rankfaktorisering. En matris A med rank R kan skrivas som en produkt av två matriser, P och Q där P har full rank i kolonnrummet och Q har full rank i radrummet. Från detta följer att P har en vänsterinvers och Q har en högerinvers och att där I är identiteten som är en R x R . Vi kan då skriva att

där vi använder oss av inverserna från vänster och höger. Från detta ser vi då att

där vi använt oss av att .

(Sorry att jag inte latexade allt, jag tål inte att göra det för mycket på windowsdatorer)

Jag blir besviken på de andra deltagarna i tråden när de helt ignorerar ditt inlägg EmmyNoether.

Ditt inlägg är helt klart den mest eleganta lösningen på problemet; kort och koncist, utan en massa svada om egenvärden, geometriska multipliciteter, algebraiska multipliciteter, självadjungerade normala operatorer, karakteristika polynom och jag vet inte vad. Det finns lösningar och så finns det lösningar.

Jag satt och fnissade lite för mig själv faktiskt, "jaha, jag antar att mitt bidrag inte gills då". Haha! :)

Upphör diskussionen av ett bevis för att ett annat har formulerats?

Men jovisst emmynoethers bevis var mycket bra och överaskande kompakt.

SeriousCephalopod skrev:Upphör diskussionen av ett bevis för att ett annat har formulerats?

Men jovisst emmynoethers bevis var mycket bra och överaskande kompakt.

Givetvis inte, jag tyckte mest det var roligt att mitt inlägg gled in mellan era där och passerade ganska obemärkt. Jag följer er diskussion också, även om jag inte riktigt ser hur beviset kan formas runt det. Det kanske klarnar!

@EN: Ditt bidrag gills i högsta grad! Detta var första gången jag stötte på rang-faktorisering (så jag var tvungen att fundera lite), men det är ju verkligen en riktigt fiffig typ av matrisfaktorisering, som (vilket framgår av ditt bevis!) verkligen är som klippt och skuren för det här problemet. Så tack för ett kort, tydligt och nästan maximalt lätttillgängligt bevis (man behöver i princip bara förstå vad rang och spår betyder!).

@Guggle: Tack igen! Jag ser vad du menar med minimalpolynomet (riktigt kort och koncist argument om man känner till att diagonaliserbarhet följer om minimalpolynomet kan uttryckas som en product av distinkta förstagradare), men approachen med spektralsatsen förstår jag fortfarande inte. Orkar du (eller någon annan som är med på noterna) ge fler ledtrådar eller en skiss av det bevis du har i åtanke? :)

Här kommer mitt eget lösningsförslag, som i princip är en variant av det som SC och Guggle redan har föreslagit.

Påstående. Om uppfyller likheten , så gäller att .

Bevis. Precis som er andra tycker jag det skulle kännas trevligt att göra något slags basbyte, sådant att både rangen och spåret blir enkelt att läsa av (notera att både rangen och spåret är bas-oberoende egenskaper hos en linjär avbildning). Det bästa vore om man kunde diagonalisera, så låt oss göra ett försök!

Första steget är då att fundera på vad kan tänkas ha för egenvärden (om det ens finns några). Vi låter därför vara en hypotetisk egenvektor med egenvärde , och noterarar att vi å ena sidan får

och å andra sidan (eftersom är en engångsmatris) får

Detta kan bara inträffa om , dvs. om eller . Så detta är tydligen de enda möjliga egenvärdena för .

För att lyckas diagonalisera måste vi nu koka ihop en bas för bestående av egenvektorer ur (de möjligen triviala) egenrummen för 0 respektive 1.

En bra början kan vara att fundera på vad dessa egenrum egentligen är för något. Som vanligt är egenrummet för 0 detsamma som nollrummet:

och eftersom är en engångsmatris är egenrummet för 1 lika med kolumnrummet (tänk på vänster- respektive högerinklusionen var för sig):

Låt oss nu ta en bas för , där , och en bas för , där . Eftersom egenrum som hör till olika egenvärden är linjärt oberoende, så kommer unionen av dessa två baser,

att vara en linjärt obereoende mängd. Samtidigt säger dimensionssatsen att . Från detta drar vi slutsatsen att är en bas av egenvektorer för .

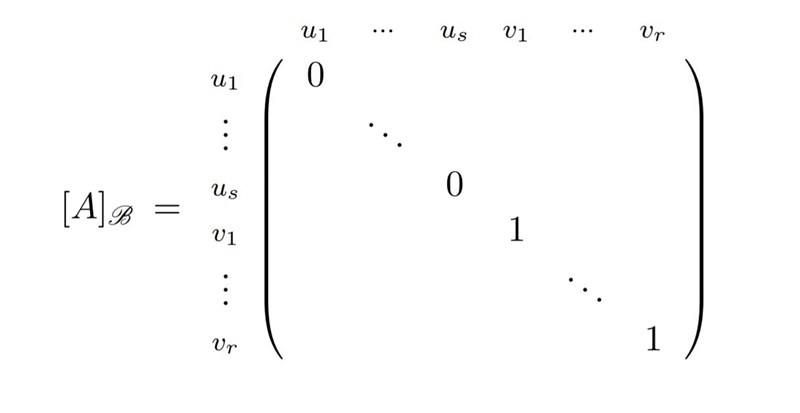

Om vi nu uttrycker i vår bas , så får vi följande matris:

och vi drar slutsatsen att

och vi drar slutsatsen att

Kommentar 1. Från resonemanget ovan kan vi dra slutsatsen att alla engångsmatriser, upp till lämpligt basbyte, har samma enkla form som den projektionsmatris vi såg i trådstarten. Ett mer vedertaget namn för "engångsmatriser" är faktiskt just projektionsmatriser. Ännu vanligare är benämningen idempotenta matriser, som redan har dykt upp ett par gånger i tråden.

Kommentar 2. Vill man göra beviset mer elementärt genom att undvika användningen av egenvärden/egenvektorer (men då samtidigt göra bevisstrategin mindre intuitiv), så kan man direkt (baserat på inspiration från ovan?) välja baser och för respektive . Enligt dimensionssatsen kommer unionen då att ha maximalt stycken element. Samtidigt spänner upp hela , eftersom varje kan skrivas som , där och det faktum att är en engångsmatris ger att . Vi drar därför slutsatsen att är en bas för , och fortsätter sedan som ovan.

Väldigt trevligt bevis!

SeriousCephalopod skrev:

Kruxet ligger som sagt i att vi endast vet att geometriska multpliciteten är mindre än den algebraiska men inte, utifrån texten, att de är lika.

Mja, om A är idempotent är dimensionen av värderummet V(A) (dvs rang(A)) är lika med antalet linjärt oberoende egenvektorer med egenvärdet 1. Det innebär att den algebraiska- och geometriska multipliciteten för egenvärdet 1 sammanfaller (och är lika med rang(A)).

Eftersom dimensionssatsen garanterar att dimensionen av N(A) är och multipliciteten av egenvärdet 0 är just kan vi dra slutsatsen att de två egenrummen tillsammans kan uppbåda n linjärt oberoende egenvektorer (varje bas till N(A) uppfyller ju ). Den idempotenta matrisen A är alltså diagonaliserbar. Ett annat sätt att formulera det är att varje egenvärdes geometriska multiplicitet är lika med dess algebraiska.

I det exempel tar du upp är A en matris där dimensionen av värderummet är 3, men där den algebraiska multipliciteten till egenvärdet 1 begränsar antalet egenvektorer till 2. Egenvektorerna till egenvärdet 1 kan inte utgöra en bas för V(A). Dessutom råder ett underskott på dimensioner (det finns bara en kvar till N(A) enligt dimensionssatsen). Vi måste alltså ge upp våra tappra försök att diagonalisera A. De två egenrummen har helt enkelt inte tillräckligt många linjärt oberoende egenvektorer.

Ett annat sätt att formulera det är att för egenvärdet 0 blev den geometriska multipliciteten strikt mindre än den algebraiska, and thats a big no-no.

Ett annat kort bevis är att hänvisa till Jordans normalform. Är matrisen skriven på Jordanform (efter ett basbyte som ju inte ändrar rang/spår) så är det uppenbart att ett Jordanblock uppfyller J^2=J omm det är en diagonalmatris med enbart ettor eller nollor. Då varje Jordanblock är diagonalt så är matrisen diagonal och vi är klara.

Annars så är ett trevligt sätt att titta på V som en direkt summa av nollrum och värderum, genom att vi sätter v=Av+(v-Av) (som varit uppe som förslag på approach tidigare).

Uppenbart så ligger Av i värderummet (där A agerar som identitet) och v-Av i nollrummet så vi skriver varje vektor som en summa av en vektor från nollrum och värderum på unikt sätt (det är trivialt att skärningen är nollvektorn). Välj en bas för vardera vektorrummen och vi är klara (igen genom att matrisen är diagonal).

JohanB skrev:

Ett annat kort bevis är att hänvisa till Jordans normalform. Är matrisen skriven på Jordanform (efter ett basbyte som ju inte ändrar rang/spår) så är det uppenbart att ett Jordanblock uppfyller J^2=J omm det är en diagonalmatris med enbart ettor eller nollor. Då varje Jordanblock är diagonalt så är matrisen diagonal och vi är klara.

Ohh, snyggt! Jag hade helt räknat bort JCF som verktyg eftersom det kräver att vi jobbar över en algebraiskt sluten kropp, och det här problemet handlar om reella matriser. Men en stunds funderande ger att detta inte är någon fara, eftersom vi enkelt kan översätta från till genom att komplexifiera!

Mer precist så kan vi till varje reellt vektorrum associera ett komplext vektorrum där vektorerna består av formella summor , där . Man kan visa att varje -bas för är en -bas för , så .

Vidare kan vi till varje operator associera en komplexifierad operator definerad genom . Det är enkelt att visa att för varje val av bas för och så kommer och att ha samma matrisrepresentation. Från detta följer att och har samma spår. Vidare kan man också visa att , vilket innebär att

dvs. även rangen förblir oförändrad om man komplexifierar.

Det är därför helt lugnt att omtolka en matris som en matris när man vill undersöka rang och spår. Ett användbart faktum som jag har aldrig reflekterat över förrut! :D

.jpg?width=80&crop=0,0,80,80)