Vad är en tensor?

Var god, förklara som om jag var två år gammal.

Jag har läst wikipedia, det står:

In mathematics, a tensor is an algebraic object that describes a (multilinear) relationship between sets of algebraic objects related to a vector space.

Men... Det förstår jag inte. Jag har även googlat "tensors for dummies" men fattar inte.

Qetsiyah skrev:Var god, förklara som om jag var två år gammal.

Jag har läst wikipedia, det står:

In mathematics, a tensor is an algebraic object that describes a (multilinear) relationship between sets of algebraic objects related to a vector space.

Men... Det förstår jag inte. Jag har även googlat "tensors for dummies" men fattar inte.

Vet inte om denna förklaring kan vara till hjälp i väntan på ett bättre svar: https://it-ord.idg.se/ord/tensor/

Tyvärr, finns det inget enkelt svar på denna fråga.

Varje disciplin verkar ha sin egen definition av tensor, och det tar år innan man förstår hur de olika definitionerna hänger samman.

Inom fysik definieras ofta en tensor som något vars komponenter transformeras som en tensor vid koordinatbyten. Alltså, en anka är ett djur som beter sig som en anka. En praktisk definition, men kanske lite otillfredsställande. Och det gör att man tror att en tensor nödvändigtvis har något med koordinatsystem att göra, vilket är lite begränsande.

Inom fysik är det även vanligt att definiera en tensor som en multilinjär funktion.

Inom kontinuum-mekanik definierar man ofta en andra ordningens tensor som en linjär operator.

Vad jag förstår, så baseras tensorer i ren matematik på kategoriteori, vilket jag har väldigt usel insikt i. Så här får någon matematiker fylla i.

Jag kan inte förklara på en tvåårings nivå, men jag antar att du kan lite linjär algebra i alla fall (annars borde du inte kommit i kontakt med begreppet tensor).

Betrakta ett vektorrum V över en kropp K (om du inte vet vad en kropp är, så tänk dig reella eller komplexa tal, dvs dina skalärer). Då har du till att börja med två slags objekt:

0) skalärer, det är elementen i K, de är i en viss mening 0-dimensionella, de har ingen riktning, det är en tensor av ordning 0

1) vektorer, de är i en viss mening 1-dimensionella, en vektor spänner upp ett 1-dimensionellt underrum, det är en (kontravariant) tensor av ordning 1

Nu kom ordet kontravariant så kanske dags att säga vad det annars är, kovariant, dvs kovektorer, så då kommer nästa objekt som du kan härleda från de två:

1') kovektorer, linjära funktionaler, dvs linjära funktioner från V till K, det är en (kovariant) tensor av ordning 1

Mängden av kovektorer bildar också ett vektorrum, dualrummet till V, V*, med samma dimension (om V har ändlig dimension). Försöker vi göra samma trick en gång till, dvs funktionaler från V* till K så visar det sig att det kan identifieras med V (om V har ändlig dimension), så dubbeldualen till V är isomorf med V. Identifieringen är att om f är en kovektor så är v(f) = f(v), dvs ett element i dualen till V* identifieras med ett element i V som jag kallade v och den funktionen v verkande på kovektorn f är med identifieringen samma som kovektorn f verkande på vektorn v.

Praktiska exempel på kovektorer är gradienten till en (olinjär) funktion f av en vektor. Annat exempel är koordinatfunktionerna till en vektor (om man fixerar en bas), en vektor v har som första koordinat x1(v), då är x1 en kovektor. På det sättet kan man tänka sig basvektorerna som kovektorer också.

Lite mer konkret så kan man skriva kontravarianta vektorer som kolumnvektorer och kovarianta vektorer som radvektorer och matrisprodukten ger då den linjära funktionalen då en kovektor verkar på en kontravariant vektor. Mer allmänt för tensorer brukar man ha kontravarianta index som superscript och kovarianta index som subscript och använda Einsteins summationskonvention för att slippa skriva summatecken överallt (index uppe med samma namn som index nere betyder summation över index från 1 till n där n är dimensionen på vektorrummet V).

Här kommer vi in på det där med basbyte också, om du byter till en ny bas f = eT med basbytesmatris T så transformeras koordinaterna X för en kontravariant vektor eX till koordinaterna Y i den nya basen med inversen till T. eX = fT^(-1)X = fY, dvs Y = T^(-1)X. Det är det som är "kontra" (motsatt), dvs koordinaterna transformeras motsatt (med inversen) till basvektorerna med basbytesmatrisen.

Då är vi redo för nästa objekt:

2) Linjära avbildningar från V till V, de tar en kontravariant vektor in och ger en kontravariant vektor ut, vi kallar det ordning (1,1) eller ordning 2 (=1+1).

En linjär avbildning med matrisen A i basen e har i basen f = eT matrisen T^(-1)AT, den transformeras kontravariant i ena index (kolumn) och kovariant i andra index (rad).

Det finns även andra varianter på ordning 2:

2') En kvadratisk form på V, den tar två kontravarianta vektorer in och ger en skalär ut, vi kallar den ordning (2, 0) eller ordning 2.

På samma sätt kan man definiera mer allmänt (multi-)linjära funktioner (linjära i varje argument) som tar p kovarianta vektorer och q kontravarianta vektorer och ger en skalär som resultat, det är en tensor av ordning (p, q), eller ordning p+q

Så om du fixerar en bas är en tensor bara en array med p+q index, en matris har två index, rad och kolumn. Men på samma sätt som en matris representerar en linjär avbildning (i en viss bas) så representerar en array med p+q index en tensor (i en viss bas).

Givet en bas, ei, för vektorrummet V så finns en naturlig bas, fj, för dualrummet V* genom att kräva fj(ei) = 0 om i != j och 1 annars.

En tensor från mekaniken är elasticitetstensorn i linjär elasticitetsteori, det är en tensor av ordning 4, den avbildar töjningstensorn (ordning 2) till spänningstensorn (ordning 2) eller nåt sånt, jag kan ha kastat om terminologin lite här, var länge sen jag läste kontinuumsmekanik.

Jag kanske kan förtydliga lite:

En skalär är en (0,0)-tensor, du kan se det som en funktion som inte tar någon kovariant vekor in och ingen kontravariant vektor in och ger en skalär som resultat

En (kontravariant) vektor är en (0,1)-tensor, du kan se den som en funktion som tar ingen kontravariant vektor in och en kovariant vektor in och ger en skalär ut, resultatet är den kovarianta vektorn applicerad på en kontravarianta vektorn, det är från identifieringen av dubbeldualen av V med V.

På samma sätt är en kovariant vektor en (1,0)-tensor.

En linjär avbildning är en (1,1)-tensor, den tar en kontravariant vektor in och ger en kontravariant vektor ut, men den kontravarianta vektorn ut kan du se som en funktion som tar en kovariant vektor in och ger en skalär ut, så det är en currifiering av funktionen som tar en kontravariant vektor in och en kovariant vektor in och ger en skalär ut

En kvadratisk form är en (2,0)-tensor för den tar två kontravarianta vektorer in och ger en skalär ut

Man kan alltså se en (p,q)-tensor som en funktion som tar k kontravarianta vektorer in och m kovarianta vektorer in och ger en resultat som är en (p-k, q-m)-tensor ut via identifieringen av dubbeldual till V och V.

Alltså kan du även se en linjär avbildning på V som en funktion som tar en kovariant vektor in och ger en kovariant vektor ut, i en fix bas får du multiplikation av matrisen för avbildningen till höger om en radvektor (som inargument) som ger en radvektor som resultat.

dioid skrev:Jag kanske kan förtydliga lite:

En skalär är en (0,0)-tensor,

Ja.

En (kontravariant) vektor är en (0,1)-tensor

Nej.

På samma sätt är en kovariant vektor en (1,0)-tensor.

Nej.

Ordet currifiering kanske behöver förklaras.

https://m.youtube.com/user/eigenchris/playlists

Hyfsat bra introduktion ovan.

Jroth skrev:dioid skrev:Jag kanske kan förtydliga lite:

En skalär är en (0,0)-tensor,

Ja.

En (kontravariant) vektor är en (0,1)-tensor

Nej.

På samma sätt är en kovariant vektor en (1,0)-tensor.

Nej.

Bra fångat, jag kastade om p och q där, texten stämmer och första inlägget stämmer. Dvs

En (kontravariant) vektor är en (1,0)-tensor

En kovariant vektor (en vektor i dualrummet) är en (0,1)-tensor.

Jag gjorde samma fel på den kvadratiska formen, den är en (0,2)-tensor och inte en (2,0)-tensor.

Laguna skrev:Ordet currifiering kanske behöver förklaras.

Bra poäng, se Wikipedia:

https://en.wikipedia.org/wiki/Currying

Det handlar om hur man kan se en funktion av två variabler som en funktion av en variabel som returnerar en funktion av andra variabeln, och generalisera det. Det är väl mer en datalogisk term än matematisk och i matematik brukar man se currifierade varianter som "samma sak", om man inte beskriver det kategoriteoretiskt. För mig var det en källa till stor förvirring när jag försökte förstå tensorer första gången, men egentligen är det inget konstigt. Hade underlättat med lite mer tydlighet i att man kan se en tensor på olika sätt genom att se currifierade varianten av tensorn som samma sak.

Om man vill fortsätta bli utmanad kan man titta på programmeringsspråket Haskell och på kategoriteori. Kombinatorer kan man också slå upp.

Men de enklaste tillämpningarna av currifiering i programmering är ganska jordnära. T o m javascript har det som kallas closures.

Nu vet jag inte om jag svävade bort fullkomligt från frågan om tensorer.

dioid skrev:Bra fångat, jag kastade om p och q där, texten stämmer och första inlägget stämmer. Dvs

Jag gjorde samma fel på den kvadratiska formen, den är en (0,2)-tensor och inte en (2,0)-tensor.

Jag är inte med på vad du menar med kvadratisk form. Låt mig ta ett konkret exempel istället för att hamna i ett träsk av definitioner. Om vi tittar på en (0,2) tensor t.ex. (den förhoppningsvis välbekanta) och låter vara komponenterna av ett objekt i så är

komponenterna till en kovariant vektor i

Med finns det en invers sådan att

Alltså kan vi säga att

(I förbigående har vi alltså etablerat ett 1-1 förhållande mellan och ) givet att metriken faktiskt existerar, för en differentierbar mångfald utan metrisk tensor kan man inte etablera ett sådant). Vi kan nu roa oss med att bilda

Jag påstår nu tre saker, 1) Ovanstående ger en ledtråd om hur man kan tolka längden av en kovariant vektor, 2) är lika mycket en kvadratisk form som och 3) är en (2,0)-tensor.

Det har du rätt i, det finns två kvadratiska former. En (0,2)-tensor som tar kontravarianta vektorer och en (2,0)-tensor som tar kovarianta vektorer och om man har en metrik så hänger de ihop via att lyfta/sänka index.

Jag försökte förklara det från linjär algebra och analysperspektiv med tanke på frågeställaren och tänkte på fallet taylorutveckling av en funktion. Då är gradienten en (0,1)-tensor (dvs en kovariant vektor) och kvadratiska formen i taylorutvecklingen är en (0,2)-tensor.

Ytterligare ett exempel på en (0,2)-tensor är skalärprodukten.

Jag hade inte tänkt dra in differentialgeometri men det är där det blir ännu mer relevant att hålla reda på vad som är kontravariant och kovariant.

Jag försöker mig på en ytterligare förenklad förklaring av vad en tensor är, för orginalfrågeställaren. Betrakta ett vektorrum V av ändlig dimension över en kropp K.

En tensor har en ordning (p,q) och en (p,q)-tensor kan man (förenklat) se som en (multi)linjär avbildning som tar q vektorer som inargument och ger p vektorer som värde/utdata (inte riktigt sant). Om p=0 är utdata en skalär. Om q=0 tar funktionen inga inargument och är då en "konstant".

Då är en (0,0)-tensor en skalär.

En (1,0)-tensor är en vektor (inget inargument och alltså bara ett möjligt utdatavärde som är en vektor).

En (0,1)-tensor är en linjär funktion som tar en vektor in och ger en skalär ut. Det kallas också linjär funktional. Ex är gradienten till en (olinjär) funktion i en fixerad punkt. Inargumentet är då en rikningsvektor (med längd 1) och utdata är riktningsderivatan i den riktningen. Här finns även som exempel på (0,1)-tensorer koordinatfunktionerna i en given bas, x1(v) ger första koordinaten för v (i den givna basen), x2(v) den andra, osv.

En (1,1)-tensor är en vanlig linjär avbildning, tar en vektor in och ger en vektor ut.

En kvadratisk form (kvadratiska termen i taylorutvecklingen kring en fix punkt) är en (0,2)-tensor där både första och andra vektorn in är samma vektor (förskjutningen i inargumentet från den fixa punkten).

En skalärprodukt är en (0,2)-tensor, den tar två vektorer som inargument och ger en skalär som utdata.

Så du har redan sett en massa tensorer utan att veta om det.

Men det finns ytterligare tolkning av en (p,q)-tensor, du kan se det som att den tar k (<= p) kovarianta vektorer och m (<= q) kontravarianta vektorer som inargument och ger en (p-k,q-m)-tensor som utdata. Här är förklaringen på lögnen i början på den här förenklade förklaringen, det är inte p vektorer som utdata utan en (p,0)-tensor som utdata, dvs en funktion som tar p kovarianta vektorer som inargument och ger en skalär som utdata. När p=1 är det ingen skillnad pga nedanstående:

En (1,0)-tensor v (dvs en vektor) kan du alltså se som en funktion som tar en linjär funktional f (en (0,1)-tensor) som inargument och ger en skalär som resultat, definitionen är v(f) = f(v).

En (1,1)-tensor A kan du då också se som en linjär avbildning från en linjär funktional f till en annan linjär funktional g. Om du ser linjära funktionalerna som vektorer i dualrummet och definierar en bas i dualrummet som är dual till basen i V och skriver dualvektorerna som radvektorer så blir det fA = g, dvs du multiplicerar argumentet till vänster om "matrisen" istället för till höger som med (kontravarianta) vektorer.

Så med den här förenklade förklaringen är en tensor bara en unifiering av begreppen skalär, vektor, gradient, linjär funktional, linjär avbildning, kvadratisk form, skalärprodukt och en generalisering till (multi)linjära funktioner från en uppsättning kovarianta och kontravarianta vektorer till tensorer av lägre ordning.

Så man kan resonera om en (multi)linjär funktion från V till linjära avbildningar, dvs från en kontravariant vektor till en (1,1)-tensor, det blir då en (1,2)-tensor, osv.

dioid skrev:Jag försöker mig på en ytterligare förenklad förklaring av vad en tensor är, för orginalfrågeställaren. Betrakta ett vektorrum V av ändlig dimension över en kropp K.

En tensor har en ordning (p,q) och en (p,q)-tensor kan man (förenklat) se som en (multi)linjär avbildning som tar q vektorer som inargument och ger p vektorer som värde/utdata (inte riktigt sant). Om p=0 är utdata en skalär. Om q=0 tar funktionen inga inargument och är då en "konstant".

Då är en (0,0)-tensor en skalär.

En (1,0)-tensor är en vektor (inget inargument och alltså bara ett möjligt utdatavärde som är en vektor).

En (0,1)-tensor är en linjär funktion som tar en vektor in och ger en skalär ut. Det kallas också linjär funktional. Ex är gradienten till en (olinjär) funktion i en fixerad punkt. Inargumentet är då en rikningsvektor (med längd 1) och utdata är riktningsderivatan i den riktningen. Här finns även som exempel på (0,1)-tensorer koordinatfunktionerna i en given bas, x1(v) ger första koordinaten för v (i den givna basen), x2(v) den andra, osv.

En (1,1)-tensor är en vanlig linjär avbildning, tar en vektor in och ger en vektor ut.

En kvadratisk form (kvadratiska termen i taylorutvecklingen kring en fix punkt) är en (0,2)-tensor där både första och andra vektorn in är samma vektor (förskjutningen i inargumentet från den fixa punkten).

En skalärprodukt är en (0,2)-tensor, den tar två vektorer som inargument och ger en skalär som utdata.

Okej!

Så du har redan sett en massa tensorer utan att veta om det.

Ja det är trevligt. Så vad är en kryssprodukt då? Vad är en determinant?

Ett ögonblick så söker jag upp "kovariant". (så konstigt att jag inte råkat klicka mig till detta på wikipedia än, jag läser runt och låtsas förstå saker hela tiden).

Jag håller på att stirra på https://en.wikipedia.org/wiki/Covariance_and_contravariance_of_vectors#/media/File:Covariantcomponents.gif

Jag kanske kommer till någon insikt om några minuter... Men jag tänker bara på jacobideterminanten, och mycket riktigt nämns den i wikipediaartikeln, men bara en gång.

Det finns som redan nämnts väldigt många ekvivalenta perspektiv på vad en tensor är.

En hyfsat kompakt formulering (som dock kanske inte riktigt bjuder på samma djupa fysikaliska insikter som den formulering som har diskuterats hittills i tråden) lyder som följer.

Definition. Låt vara ett ändligt-dimensionellt vektorrum över en kropp (t.ex. de reella talen eller de komplexa talen). En -tensor på är då en multilinjär avbildning

där är det så kallade dualrummet till , som är mängden av alla linjära avbildningar (sådana avbildningar kallas ofta för funktionaler) utrustad med punktvis addition och multiplikation med skalärer. (Övning: Visa att är ett vektorrum över .)

Ett par exempel på funktionaler (övertyga dig gärna om att de verkligen är linjära!):

med ,

med ,

med .

Exempel 1: Den vanliga skalärprodukten är ett exempel på en -tensor på , eftersom den är en bilinjär avbildning med .

Exempel 2: Determinanten ger upphov till en -tensor på , eftersom vi har en multilinjär avbildning med .

Exempel 3: Linjära avbildningar kan, med lite välvilja, sägas vara samma sak som -tensorer på .

Idén är följande: Varje linjär avbildning kan användas för att konstruera en -tensor , definierad av .

En klassisk övningsuppgift i (en andra kurs i) linjär algebra är att vissa följande saker:

(1) är verkligen en multilinjär avbildning.

(2) Varje linjär avbildning ger på detta vis upphov till en unik -tensor (dvs. om så gäller ).

(3) Varje -tensor på kan uttryckas som för någon linjär avbildning .

Slutsatsen är att vi har en bijektion (alltså ett 1-till-1-förhållande) mellan mängden av alla linjära avbildningar och mängden av alla -tensorer på (man kan rent av visa att vi får en så kallad isomorfi), vilket gör det typ berättigat att sätta likhetstecken mellan de två begreppen.

Många fler (och mer intressanta!) exempel på tensorer finns i differentialgeometrin och fysiken, och det är när man stöter på dem som själva tensorbegreppet börjar bli verkligt användbart. Ett av den mest berömda exemplen är Riemann-kurvatur-tensorn, som är en -tensor som finns på tangentrummet i varje punkt på en Riemann-mångfald. Den är intressant ur ett matematiskt perspektiv, men om jag har förstått saken rätt motiveras den främst av att den spelar en central roll i allmän relativitetsteori. (Någon som faktiskt kan något om fysik kan kanske säga något mer om detta?)

Väldigt bra och kompakt framställning av oggih.

Om man har en bas för V med en tillhörande dual bas för V* ( V* definieras så att (Kronecker delta)), så kan kan varje (1,1)-tensor T skrivas mha komponenter enligt

= , här är summering över index i och j implicit (googla Einsteins summakonvention).

.

Den linjära operatorn A som är kopplad till T i oggihs diskussion kan nu definieras genom

A() = , summering implicit över båda index igen.

Det är inte svårt att visa att , med denna definition av A.

Man kan även visa att A:s matrisrepresentation M relativt basen är kopplad till komponentframställningen av T på ett väldigt enkelt sätt, det är nämligen så att

.

Bra skrivet! Ifall någon skräms av tensorprodukterna och Einstein-konventionen (som dock är väldigt bra att vänja sig vid) så skulle man kanske kunna uttrycka det något i stil med följande:

Låt vara en bas för vektorrummet . Då är en bas för dualrummet , där är definierad så att

dvs. "plockar ut" den :te koordinaten för en vektor uttryckt i basen .

På samma sätt som en linjär avbildning bestäms av vart den mappar basvektorerna, så bestäms en -tensor på vårt vektorrum av vart den mappar alla par av formen . Om vi inför beteckningen

så kommer det gälla att

Den motsvarande linjära operatorn kan nu definieras genom att sätta

dvs.

vilket, precis som Pantamera påpekar, innebär att det :te elementet i matrisrepresentationen för med avseende på basen blir just .

Vi ser nu att för varje funktional och varje vektor så kommer det gälla att

vilket var precis vad vi ville åstadkomma!

Hej, jag läste precis det här. Jag vill fråga:

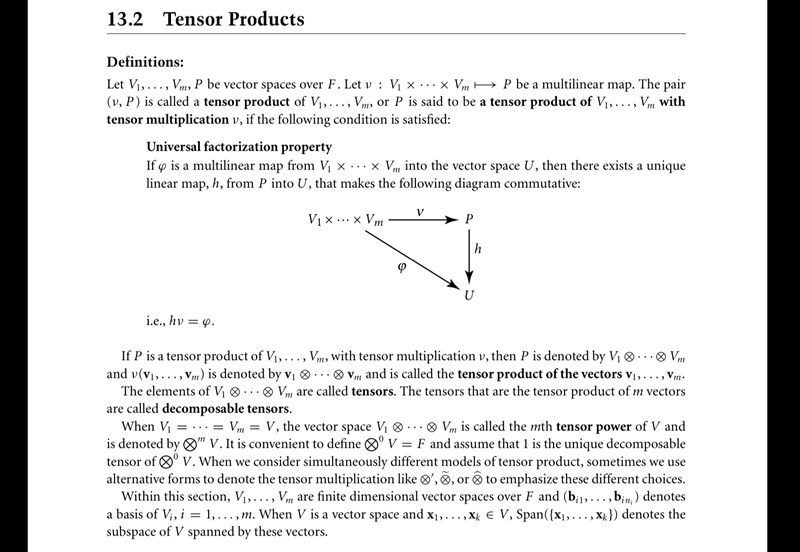

- är ”the pair (v, P)” en mängd? En mängd av avbildningar v till P?

- ”this is called the tensor product of V1, V2, ... Vm”, det saknas väl lite information? Är det inte viktigt att säga att avbildningen är till P (vilket P man nu har valt)?

- Är hv sammansättningen av h och v?

P är ett vektorrum och v är en avbildning från V1 x ... x Vm till P.

P är tensorprodukten av vektorrummen V1, ...,Vm, dvs

P = V1...Vm. Det finns olika sätt att konkret konstruera P, men om jag kommer ihåg rätt är alla konstruktioner isomorfa.

Ja, hv är sammansättning.

Vilken bok är det?

Det är Handbook of linear algebra av Leslie Hobgen (men varje kapitel har en egen förafaatare). Det var en kul bok, den är vetenskapligt populärvetenskaplig.

PATENTERAMERA skrev:P är ett vektorrum och v är en avbildning från V1 x ... x Vm till P.

P är tensorprodukten av vektorrummen V1, ...,Vm, dvs

Jaha... okej...

P = V1...Vm. Det finns olika sätt att konkret konstruera P, men om jag kommer ihåg rätt är alla konstruktioner isomorfa.

Ja det stämmer, det skrev de nån annanstans.

Ja, hv är sammansättning.

Jaha, vilket konstigt skrivsätt. Från att jag ställe frågan hann jag hitta samma definition i en annan bok och där använde de den bekanta ringsymbolen för att beteckna sammansättning. Är det här också en sån insidergrej för experter där man av sammanhanget förstår ändå och struntar i sybolen?

Vänta, är det samma sats?

Observera att två olika begrepp är i spel här: en tensor är en viss typ av multilinjär avbildning, medan tensorprodukten av två (eller flera) vektorrum är ett vektorrum. Så i grund och botten är tensorer och tensorprodukter helt olika objekt, även om de hör ihop, så tillvida att båda dyker upp i samband med att man diskuterar begreppet multilinjäritet (och man kan t.ex. använda tensorprodukter för att på uttrycka vad en tensor är).

Spontant tänker jag att det kanske inte är det mest pedagogiska att angripa båda begreppen samtidigt när man är ny på detta. Särskilt begreppet tensor är lite rörigt och som vi tidigare har påpekat i tråden finns det många olika perspektiv på vad en tensor är, vilket jag själv i alla fall har upplevt (och ibland fortfarande upplever) som förvirrande. (För egen del lärde jag mig vad en tensorprodukt var flera år innan jag lärde mig vad en tensor var, men det är säkert olika, och en mer fysiskt skolad person tycker säkert att det är vansinne att inte diskutera tensorer redan i en första linalg-kurs.)

Nähä? En tensor är ett element i tensorprodukten som är ett vektorrum? Det är väl det som står precis under bilden i första bilden jag skickade?

och en mer fysiskt skolad person tycker säkert att det är vansinne att inte diskutera tensorer redan i en första linalg-kurs

Nääääää? Då får den vara väldigt lång den kursen.

Men okej, nu har vi redan rört till den här tråden genom att prata om tensorer och tensorprodukter, så låt mig ändå säga någonting om tensorprodukter.

Låt oss börja med att komma överens om vad tensorprodukten ens är för något! Och låt oss för enkelhetens skull begränsa oss till tensorprodukter av två vektorrum (konstruktionen för tensorprodukten av fler vektorrum är analog).

Konstruktion. Låt och vara två vektorrum över en kropp . Tensorprodukten kan (lite löst) definieras som mängden av alla linjärkombinationer av par , där vi har infört följande identifikationer som "imiterar" bilinjäritet:

- för alla och .

- för alla , och .

- för alla och .

- för alla , och .

Efter att vi har gjort de här identifikationerna använder vi notationen i stället för , och kan då byta ut mot likhetstecken. Det är relativt enkelt (men kanske inte prioriterat för dig just nu) att se att detta är ett vektorrum under addition och skalning av de här linjärkombinationerna (det enda som kräver lite eftertanke är att övertyga sig om att operationerna blir väldefinierade).

I och med att vi har gjort de här bilinjäritetshärmande identifikationerna så får vi en del intressanta räkneregler, som det kan ta lite tid att vänja sig vid, men det är egentligen inga stora konstigheter, och det är värt att alltid komma ihåg att tensorprodukten i grund och botten bara består av linjärkombinationer av symboler på formen som uppfyller vissa räkneregler.

Sidenote: Om man vill vara mer formell kan man formulera identifikationerna jag beskrev ovan som att man bildar ett kvotrum (vilket du kanske redan har stött på i något annat sammanhang?) av det så kallade fria vektorrumet över .

Ytterligare en sidenote: Om är en bas för , och är en bas för , så kommer att bara en bas för .

Vid första anblicken framstår detta säkert bara ett nytt och lite konstigt sätt att bilda ett vektorrum från två redan befintliga vektorrum, men det visar sig också vara en väldigt användbar konstruktion för att förstå bilinjäritet (och mer generellt: multilinjäritet, om man tar tensorprodukten av flera vektorrum).

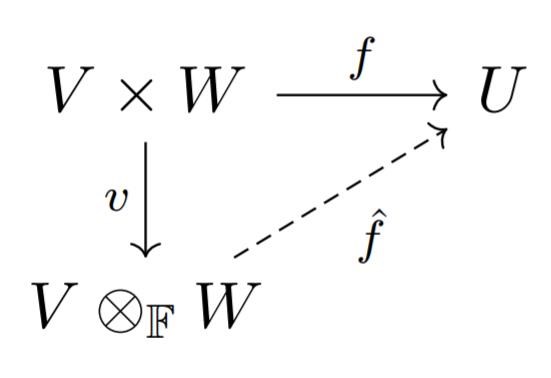

Mer precist så har tensorprodukten den lite magiska egenskapen att varje bilijär avbildningar på "går via en" linjär avbildning på tensorprodukten på ett unikt sätt. I den här bloggposten beskrivs det som att tensorprodukten fungerar som en slags "gatekeeper" som alla bilinjära avbildningar på väg ut ur måste passera (och som i samband med en sådan passage förvandlar bilinjäritet till linjäritet).

Mer precist gäller det att för varje linjär avbildning (där är något vektorrum över och är en funktion som är linjär i båda komponenterna), så finns det en unik linjär avbildning sådan att följande diagram kommuterar:

där är avbildningen (som är bilinjär genom själva konstruktionen av tensorprodukten).

Detta kanske inte är tillräckligt för att övertyga dig om tensorprodukters storheten i det här skedet, men ju mer linalg du läser, desto klarare tror jag det kommer bli att detta är en big deal. Faktum är att det är en så pass big deal att en del abstrakt lagda algebraiker föredrar att se den här "gatekeeper-egenskapen" (som formellt brukar kallas den universella egenskapen hos tensorprodukten) som den definierande egenskapen hos tensorprodukten.

Det man gör då är att man säger att en tenorprodukt av två vektorrum och består av två bitar data:

- ett vektorrum

- en bilinjär avbildning ,

som tillsammans uppfyller den universella gatekeeper-egenskapen.

A priori öppnar detta upp för att det skulle kunna finnas flera olika tensorprodukter av och , men räds icke: som redan har påpekats i tråden visar det sig att alla sådana tensorprodukter kommer vara isomorfa, och då kan vi lika gärna använda inkarnationen som vi konstruerade ovan (eller någon annan modell om t.ex. som fungerar när man jobbar med ändligt-dimensionella vektorrum).

Det här sättet att definiera matematiska objekt, där man utgår från utifrån en definierande "universell egenskap" som berättar hur objektet interagerar med avbildningar på olika sätt, är väldigt populärt (speciellt bland kategori-teoretiskt sinnade matematiker). Som du redan har sett kan man till exempel använda det för att beskriva vad det fria vektorrummet över en mängd är. Det kan även användas för att definiera produkter, direkta summor, kvotrum med mera... (Googla gärna för att se hur deras universella egenskaper ser ut!)

I linalg är det mest en fråga om personliga preferenser om man vill eller lite vill använda universella egenskaper för att definiera saker, och det är verkligen inget konstigt om du just nu tycker att det bara är onödigt abstrakt och förvirrande i det här läget. Men i andra delar av matematiken (t.ex. homologisk algebra, algebraisk topologi och algebraisk geometri) där man använder kategoriteori mer seriöst är det nästan ett måste att tänka i termer av universella egenskaper.

Qetsiyah skrev:En tensor är ett element i tensorprodukten som är ett vektorrum? Det är väl det som står precis under bilden i första bilden jag skickade?

Det är sant! Därmed kan alltså begreppet 'tensor' syfta på två olika saker: en slags multilinjär avbildning, eller ett element i en tensorprodukt. Så vitt jag vet finns det ingen helt snygg koppling mellan de två användningarna, utan det är som jag ser det genuint förvirrande terminologi som jag bara kan beklaga å matematikämnets vägnar :)

Är det här också en sån insidergrej för experter där man av sammanhanget förstår ändå och struntar i sybolen?

Precis så är det! Jag är personligen inget stort fan, bland annat eftersom det leder tankarna till multiplikation (där vi ju alla är vana sedan grundskolan att skippa symbolen), och lyckligtvis verkar de flesta hålla med mig, för jag tycker det är rätt sällan mer ser underförstådd sammansättning.

- Att jag sett kvotrum ”i nåt annat sammanhang”? Det är så grundläggande, vad för speciellt sammanhang tänker du? Jag är inte så fräsch ppå det dock.

- Varför skriver du tensorprodukttecknet med F? Vad vill du betona? Att de vrummen är över samma kropp? Det tycker jag är självklart redan.

- Det exakt denna abstraktion jag gillar, har du inte märkt det av mina frågor? Jag försökte kolla lite material om singulärvärdesuppdelning idag, men det var väldigt olockande. Jag vill lära mig kategoriteori så snart som möjligt, och abstrakt algebra när jag känner mig färdig med linjär algebra. Och lie teori någon vacker dag haha.

Det är sant! Därmed kan alltså begreppet 'tensor' syfta på två olika saker: en slags multilinjär avbildning, eller ett element i en tensorprodukt. Så vitt jag vet finns det ingen helt snygg koppling mellan de två användningarna, utan det är som jag ser det genuint förvirrande terminologi som jag bara kan beklaga å matematikämnets vägnar :)

- åh... ojdå? Men det är det förstnämnda som alla försökt förklara i tråden här?

- Finns det nåt intressant att säga om inre produktens relation till detta? Jag råkar ju veta att det är en bilinjär form.

Qetsiyah skrev:Att jag sett kvotrum ”i nåt annat sammanhang”? Det är så grundläggande, vad för speciellt sammanhang tänker du?

Låt vara ett vektorrum och låt vara ett underrum. Kvotrummet erhålls då genom att man gör identifikationen om och endast om (intuitivt: man sätter allt i till 0). (Det här går att göra mer formellt genom att prata om ekvivalensrelationer och ekvivalensklasser.)

Enkelt exempel: Kvotrummet , där , erhålls genom att vi identifierar alla vektorer som har samma -komponent.

Vår konstruktion av tensorprodukten skulle nu kunna beskrivas som att vi sätter , där

- är det fria vektorrumet över (som har mängden av alla par som bas),

- är underrummet som spänns upp av alla differenser på formen , , och för , och .

Detta är viktigt, men det är kanske ingenting som man behöver fokusera på den allra första gången stöter på tensorprodukten. Det är betydligt viktigare att ha en känsla för hur beräkningar i en tensorprodukt fungerar, och undvika de vanligaste tankefelen (t.ex. gäller det inte att ).

Varför skriver du tensorprodukttecknet med F? Vad vill du betona? Att de vrummen är över samma kropp? Det tycker jag är självklart redan.

Smaksak! Jag tycker det finns en poäng med att skilja på (för tensorprodukten av vektorrum) och (för tensorerna som spänner upp en tensorprodukt).

Jag försökte kolla lite material om singulärvärdesuppdelning idag, men det var väldigt olockande.

Nu går jag off topic, men jag måste ändå snabbt påpeka att SVD är väldigt coolt! Dels kan man göra massa roliga saker med det i dataanalys, men även om du inte går igång så mycket på tillämpningar just nu, så borde du kunna uppskatta att SVD-satsen ger oss väldigt mycket kontroll över linjära avbildningar! Det den säger är ju i grund och botten att varje linjär avbildning kan brytas ner i extremt enkla steg:

- En ortogonal tranformation (dvs. någon slags kombination av rotationer och reflektioner).

- Skalning med någon skalär längs -axeln.

- ...

- Skalning med någon skalär längs -axeln.

- Ytterligare en ortogonal transformation.

Eftersom vi förstår rotationer, reflektioner och skalningar väldigt väl, så får detta sägas vara väldigt goda nyheter - särskilt som det finns effektiva algoritmer för att faktiskt beräkna SVD:er även för relativt stora matriser!

Jag själv blev betydligt mindre misstänksam mot linjär avbildningar efter att jag lärde mig detta ^_^

Jag vill lära mig kategoriteori så snart som möjligt, och abstrakt algebra när jag känner mig färdig med linjär algebra. Och lie teori någon vacker dag haha.

Du har mycket vacker matematik framför dig!

Finns det nåt intressant att säga om inre produktens relation till detta? Jag råkar ju veta att det är en bilinjär form.

Ja! Det enklaste man kan säga är detta:

Låt vara ett vektorrum över , och låt vara en inre produkt på . Då är med mycket riktigt en bilinjär avbildning, så enligt den universella egenskapen för tensorprodukter inducerar en unik linjär avbildning sådan att .

Om tensorprodukten har något med tensorer att göra :)?

Om är linjär s och linjär r, så är tensorprodukten linjär (s+r)

Mängden av alla sådana funktioner på kan tecknas

Applicerar vi en vektorstruktur på mängden samt identifierar V med tangentrummet i punkten p på en underliggande mångfald M så börjar vi komma någonstans...

Varje element i mängden är en typ (r,s)-tensor.

Vi lägger särskilt märke till att och .

Något ytterligare lossnade denna regniga höstkväll och jag måste skriva ner det innan det försvinner.

För det första: något speciellt händer då tensorprodukten tas mellan ett vektorrum och dess dual, istället för två gotyckliga vektorrum.

För det andra: konkretisering med matriser, tensorrank och enkla tensorer. På engelska wiki om tensorprodukter finns ett obehagligt konkret exempel på yttre produkten mellan två vektorer i Rn och Rm som blir en matris med storlek nxm. Tensorprodukten är ett vrum med basen (ei⊗fj).

För det tredje: angående den universiella egenskapen är det som ska betonas väldigt hårt att f-hatt är unik för varje f.

För det fjärde: ko/kontravarians, tensorer från fysiken särskilt metriktensorn. Tensorer är saker som beskriver saker utan tillgång till referenssystem genom att ta baka in informationen om sakens transformationegenskaper i själva saken, typ. Saken blir alltså beskriven "intrincically" på engelska.

Denna videoserie (vilket jag nu ser att PATENTERAMERA rekommenderade innan, men den kändes för svår då) kollade jag på (men behövde hoppa över vissa delar) och fick den största aha!:n hittills vid 7:12 i video 11 där jag insåg att det där var en tensorprodukt fast videoskaparen undvek ⊗ tecknet. Resten av serien var också mycket intuitiv.

När jag kommit en bit längre fram kan jag ge feedback till dioids tre utförliga förklaringar (tack för att du är så tålmodig). Det hade varit bra om du förklarade, lika förenklat som resten, vad en kontra och kovariant vektor är. Vid mars detta år tror jag inte att jag var så bekant med dualrummet än, så det hindrade också mig att förstå. Dina förklaringar är centrerade kring storleken (p, q), och du ger exempel på några vanliga kombinationer av p och q. Det blir väldigt konkret och storleken är såklart en viktig egenskap, men det känns inte som att det fångar vad en tensor egentligen gör. Vad gör en tensor om vi bortser från dess typ?

Det verkade dock vara oggihs första förklarings syfte vilket var bra. Men fortfarande skulle jag säga att förklaringen var för svår i relation med vad jag kunde då. Jag tror att det var ungefär då jag började intressera mig för algebra aspekter av linjär algebra och hade inte kommit så långt. Jag tror att för många begrepp var halv-främmande (jag skulle kunna förstå mig på det med ansträngning, men för svårt att faktiskt använda det, särskilt tillsammans med andra halv-främmande koncept). Summan av främmandeheten blev för stor.

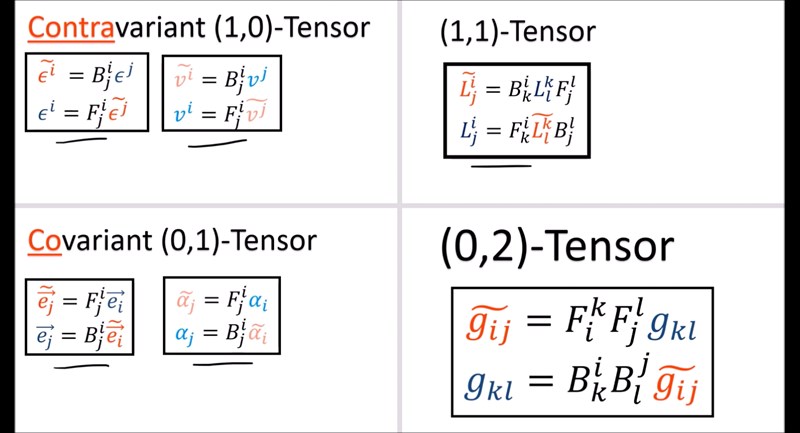

Om jag hade gått tillbaks skulle jag säga till mig själv att läsa på om ko och kontrovarianta vektorer först, sedan reflektera själv rent konceptuellt om vad som händer med funktionaler och avbildningar vid basbyten. Självklart även einsteins summakonvension, vilket jag lärde mig så sent som denna höst.

Jag tror att de röda och blåa sakerna är tensorer och de svarta sakerna är tal med flera index (vad kallas dem?), är det rätt? Visst är de svarta sakerna det som PATENTERAMERA och oggih diskuterade med operatorerna T och A och elementen i matrisen M innan tråden spårade mot tensorprodukten?

Nej, de svarta grejerna definierar transformationen från ett koordinatsystem till ett annat .

Du har stött på dem i andra skepnader tidigare, och då kallades de förmodligen saker som jakobimatris eller basbytesmatris. Jämför med ekvationerna (transformation fram- och baklänges)

Edit: Med andra ord gäller

Okej, den där bilden visar alltså hur tensorer (dess komponenter) transformeras då basen byts?

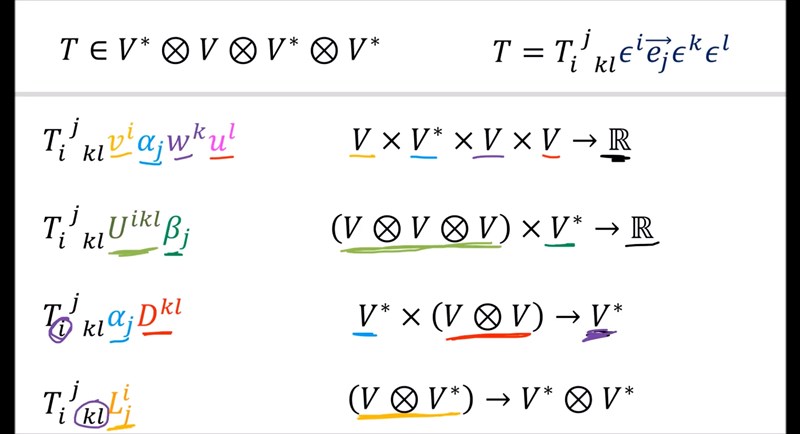

Och den här bilden visar tensorers action på andra tensorer:

I det övre högra hörnet, har han struntat i ⊗ symbolen? Han sa tidigare i videon att han skulle göra det.

Edit. Ja, precis.

Ja, det är kanske lite opedagogiskt, men på gott och ont är struntar man för det mesta i att skriva ut . I många fall struntar man i basen också.

Om t.ex. tensorn T är ett element i med , där och så är

De enskilda koefficienterna för varje och är alltså komponenter, ungefär som vektorn kan skrivas som en lista av tal, utan bas.

I praktiska sammanhang skriver man som sagt nästan aldrig ut basen explicit och man kallar för en tensor, trots att det "egentligen" är tensorns komponenter. På samma oblyga sätt kallar man också tensorfält för tensorer.

Yes!

Tensorn i bilden har fyra index, men under j har han lagt in ett mellanrum, det behövs väl inte? Vad vill han betona? Indexens ordning spelar väl ingen roll? Ifall man väljer att skriva ut baserna framför spelar väl ordningen ingen roll där heller?

Det spelar roll.

Som du ser skriver han att T , så det andra argumentet i funktionen skall var en kovektor.

T().

Men jag tolkade det som att argumenten inte ens behövde vara ordnade... Det verkar inte finnas ett bestämt antal (eller ens typ av) argument som tensorer måste få, men beroende på vad den får ger den element i olika målrum. Så skrivsättet T( , , , ,) är väl inte så bra överhuvudtaget?

Vi behöver väl inte stoppa in någon kovektor alls, tex i andra exemplet om vi bara tar den gröna U^ikl. Eller??

Vid 3:50 här så verkar det så.

Du måste skilja på hur vi definierar en tensor (och definitionen av en tensors komponenter relativt en given bas) och olika operationer som du kan göra med tensorer.

Hur definierar du en tensor?

Hur definierar du en tensors komponenter relativt en bas {ei}.

Hur definierar vi kontraktion av en tensor? Hur ser kontraktion ut när vi representerar tensorn med komponenter?

Hur definierar vi tensorprodukten? Hur ser tensorprodukten ut när vi representerar tensorer med komponenter?

Det här är en väldigt bra video som adresserar många av de saker som har diskuterats hittills i tråden, och dessutom gör lite reklam för differentialgeometri och representationsteori:

Tempot är ganska högt och vissa saker nämns bara i förbigående, men som någon skriver i kommentarerna är det en bra sammanfattning att regelbundet återkomma till i takt med att ens förståelse för tensorer utvecklas.

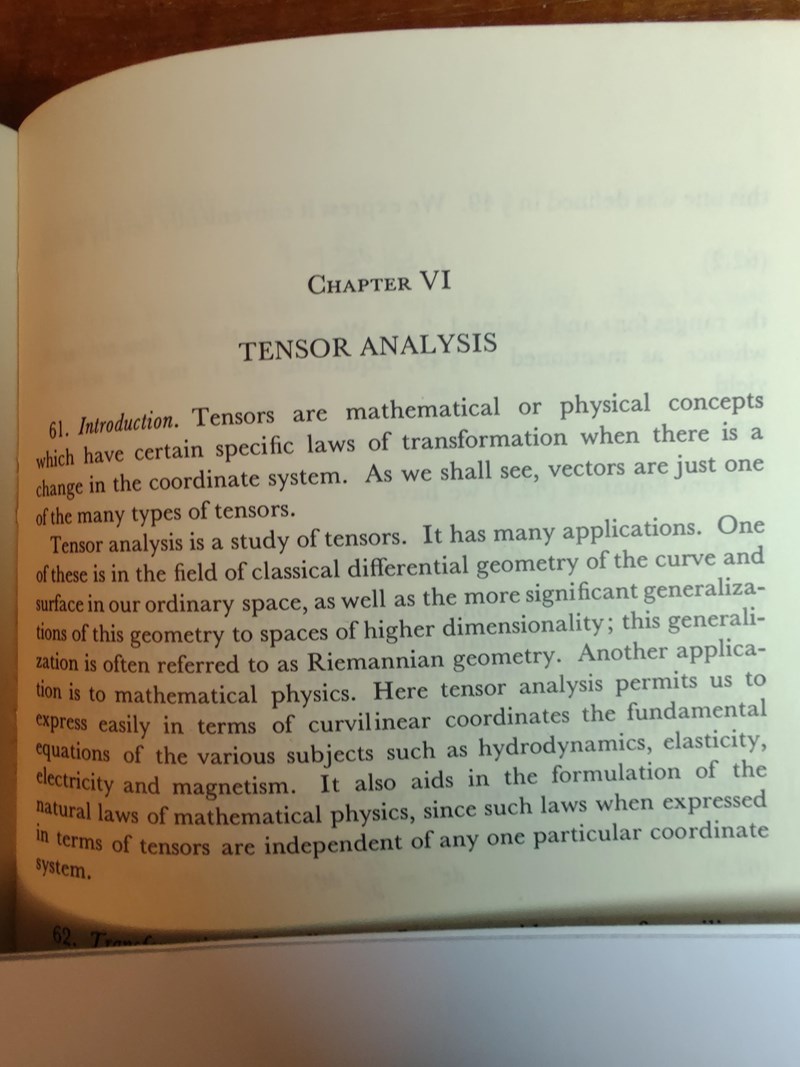

Nedanstående är ett utdrag ur en liten och verkligen utmärkt introduktion till vektorer och tensorer:

G.E. Hay: Vector & Tensor Analysis. (Dover Publications, New York)

Den publicerades 1953 och jag vet inte om det går få tag på den nu.

Qetsiyah skrev

Men jag tolkade det som att argumenten inte ens behövde vara ordnade... Det verkar inte finnas ett bestämt antal (eller ens typ av) argument som tensorer måste få, men beroende på vad den får ger den element i olika målrum. Så skrivsättet T( , , , ,) är väl inte så bra överhuvudtaget?

Vi behöver väl inte stoppa in någon kovektor alls, tex i andra exemplet om vi bara tar den gröna U^ikl. Eller??

Vid 3:50 här så verkar det så.

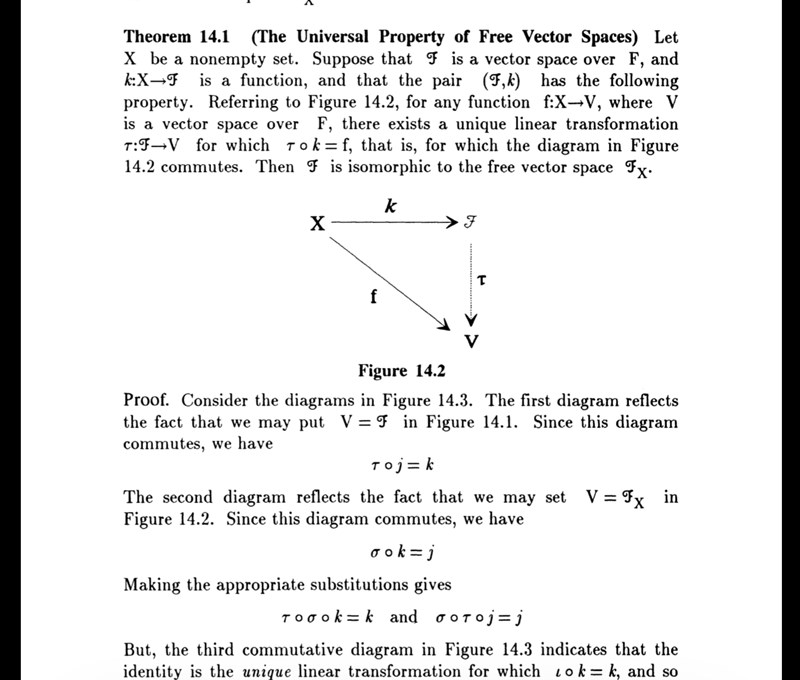

Detta intryck var rätt när jag skrev det, men jag skrev det inte så bra. Här läste jag i en bok det som bekräftar det (Detta är Steven Romans Advanced linear algebra):

Urklipp från boken

Jroth skrev

Om tensorprodukten har något med tensorer att göra :)?

Om $$f: Vs→Rf:\,V^s\to\mathbf{R}$$ är linjär s och $$g: (V*)r→Rg:\,(V^*)^r\to\mathbf{R}$$ linjär r, så är tensorprodukten linjär (s+r)

$$f⊗g: Vs×(V*)r→Rf\otimes g:\,V^s\times (V^*)^r\to\mathbf{R}$$

$$f⊗g=g(X1,…,Xs,ω1,…,ωr)=f(X1,…,Xs)g(ω1,…,ωr)f\otimes$$

Mängden av alla sådana funktioner på Vs×(V*)rV^s\times(V^*)^r kan tecknas

$$F_s^r=(V*)s⊗Vr\mathfrak{F}^r_s=(V^*)^s\otimes V^r$$

Applicerar vi en vektorstruktur på mängden samt identifierar V med tangentrummet i punkten p på en underliggande mångfald M så börjar vi komma någonstans...

Varje element i mängden är en typ (r,s)-tensor.

Vi lägger särskilt märke till att och

Ja, makes complete sense!

Jag använder numera denna tråd som tensor-dagbok, när jag då och då återkommer och undersöker saken. Det känns som att snart är jag klar, och när jag är det ska jag ge mig på en förklaring som jag själv hade varit nöjd med, med inspiration av era svar, och insikter jag gjort själv.

Jag har här en fråga:

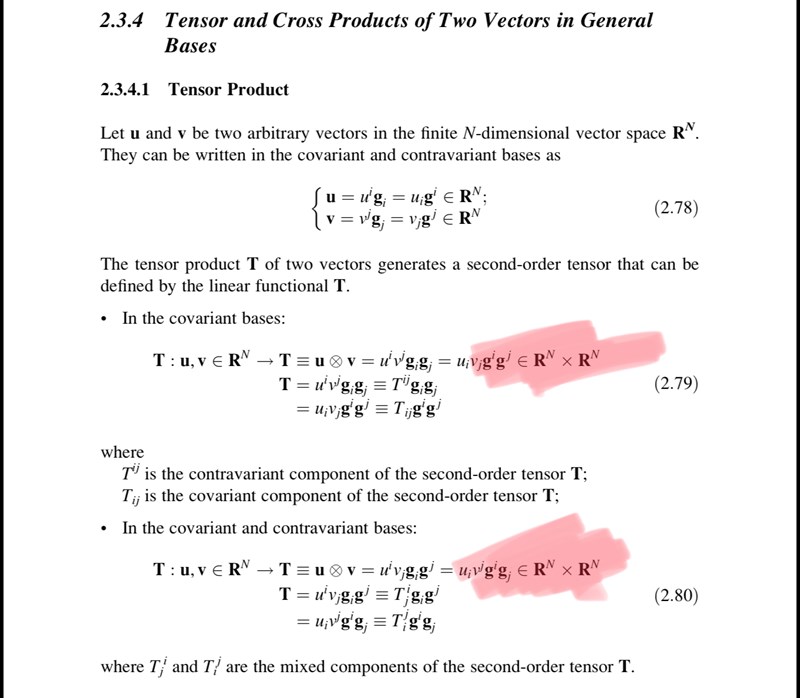

Urklipp från boken Tensor analysis and introductory differential geometery for physicists and engineers:

Men tensorn u⊗v är väl inte alls element i R3xR3? Den är element i R3⊗R3...? Ett kryss är väl bara kartesisk parbildning?

Och de betecknar tre olika saker med samma tecken (stora T): 1) den tensorproduktsskapande bilinjära avbildningen 2) tensorprodukten och 3) tensorn?

Det är också stötande hur de misshandlar skrivsättet funktion: mängd —> mängd. (Jag har dock varit lockad att skriva sådär för att spara plats, men jag vet att det är fult)

Här finns 210(!) sidor om de olika perspektiven på tensorbegreppet (kovariance/kontravarians, multilinjära avbildningar och tensorprodukter) som kanske kan vara till hjälp! Jag har bara läst några sidor hittills, men det verkar vara bra grejer: