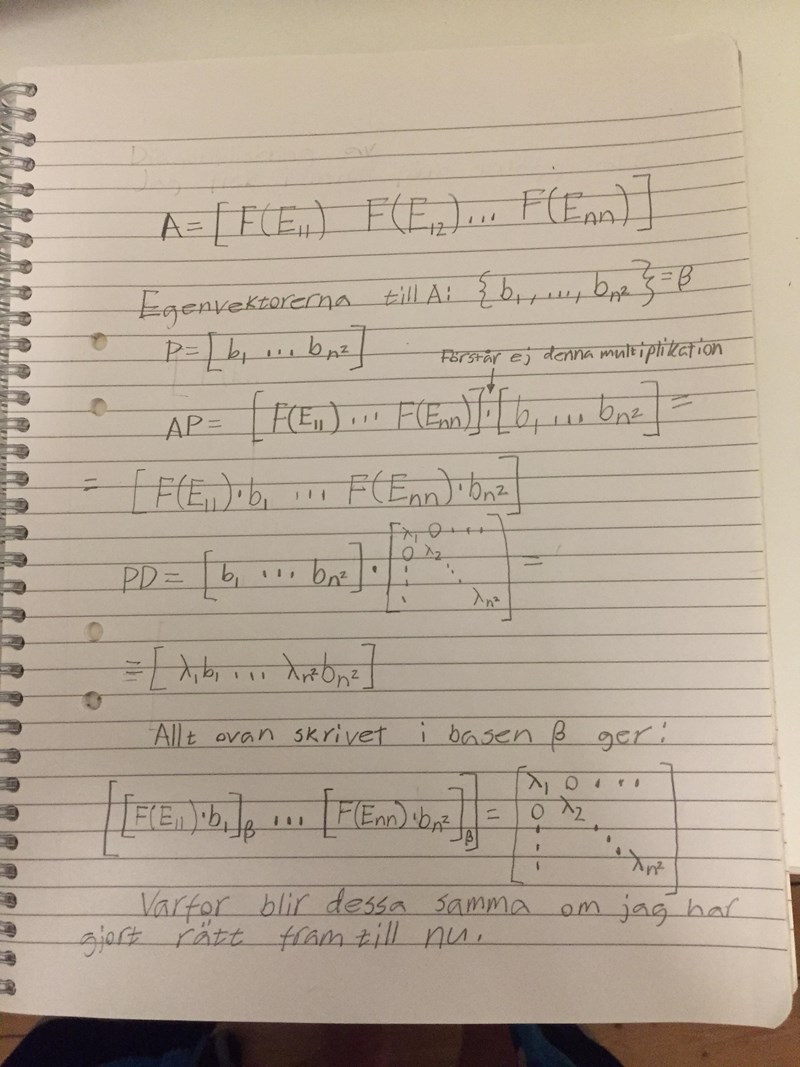

Linjär algebra, avgör om avbildningen är diagonaliserbar

Jag förstår inte riktigt hur egenvärdet som är lika med 2 för symmetriska matriser och summan av dess egenrums dimension och nollrummets dimension leder till att avbildningen F är diagonaliserbar. Någon som kan bevisa detta, alternativt ge en väldigt väl grundad förklaring. Alla bevis om detta i min bok berör endast rad och kolumn vektorer och det står inget om dimensioner för matriser.

Tack på förhand!

Kul uppgift! Det är inte konstigt att man blir lite förvirrad första gången man stöter på ett vektorrum där vektorerna är matriser, så det gäller att ta det lugnt här och inte låta sig skrämmas!

Låt oss bryta ner argumentet i mindre bitar, så att det blir lättare att identifiera vilka bitar det är som förivrrar dig.

1. Grunden för hela lösningen är följande faktum: En linjär avbildning är diagonaliserbar om och endast om vi kan hitta en bas för bestående av egenvektorer. Är du med på varför detta gäller?

Det de gör i lösningsförslaget är att de konstruerar just sådan bas av egenvektorer, nämligen mängden

2. De börjar med att visa att det verkligen rör sig om egenvektorer. Mer precist så har elementen på formen och egenvärdet 2, och de som har formen har egenvärdet 0. Är du med på hur de kommer fram till detta?

3. Nästa steg är att visa att verkligen är en bas, alltså en linjärt oberoende mängd som spänner upp .

De nämner det inte rakt ut, men elementen i mängden är linjärt oberoende. Det är ganska enkelt att övertyga sig om att att elementen i är linjärt oberoende, och att elementen i är linjärt oberoende (är du med på hur?). Vidare så gäller det allmänt att egenvektorer med olika egenvärden är linjärt oberoende från varandra (vet du varför?), och vi kan därför dra slutsatsen att hela är linjärt oberoende.

4. Sist men inte minst visar de att elementen i spänner upp hela vektorrummet .

Det tycker jag egentligen att man skulle kunna visa direkt, genom att utnyttja faktumet att varje -matris kan skrivas som summan av en symmetrisk och en skev-symmetrisk matris (vet du hur man visar detta?).

Men det de gör i lösningsförslaget är i stället att de utnyttjar ett litet trick, som ni säkert har gått igenom i kursen. Det gäller nämligen generellt för ett ändligt-dimensionella vektorrum att om man har en linjärt oberoende delmängd där antalet element är lika med , så måste vara en bas för (man behöver alltså inte kontrollera att verkligen spänner upp hela vektorrummet , utan det får man "på köpet" om antalet element i är korrekt).

I det här fallet är det ganska lätt att räkna sig fram till att antalet element i är (förstod du hur de kom fram till det?), och detta är precis lika med dimensionen för (är du med på varför dimensionen är just ?).

Slutsats: Mängden är en bas för bestående av egenvektorer, och avbildningen är alltså diagonaliserbar.

Bonusfråga: Hur ser matrisrepresentationen för ut med avseende på basen som vi just hittade (exempelvis för )?

oggih skrev:Kul uppgift! Det är inte konstigt att man blir lite förvirrad första gången man stöter på ett vektorrum där vektorerna är matriser, så det gäller att ta det lugnt här och inte låta sig skrämmas!

Låt oss bryta ner argumentet i mindre bitar, så att det blir lättare att identifiera vilka bitar det är som förivrrar dig.

1. Grunden för hela lösningen är följande faktum: En linjär avbildning är diagonaliserbar om och endast om vi kan hitta en bas för bestående av egenvektorer. Är du med på varför detta gäller?

Det de gör i lösningsförslaget är att de konstruerar just sådan bas av egenvektorer, nämligen mängden

2. De börjar med att visa att det verkligen rör sig om egenvektorer. Mer precist så har elementen på formen och egenvärdet 2, och de som har formen har egenvärdet 0. Är du med på hur de kommer fram till detta?

3. Nästa steg är att visa att verkligen är en bas, alltså en linjärt oberoende mängd som spänner upp .

De nämner det inte rakt ut, men elementen i mängden är linjärt oberoende. Det är ganska enkelt att övertyga sig om att att elementen i är linjärt oberoende, och att elementen i är linjärt oberoende (är du med på hur?). Vidare så gäller det allmänt att egenvektorer med olika egenvärden är linjärt oberoende från varandra (vet du varför?), och vi kan därför dra slutsatsen att hela är linjärt oberoende.

4. Sist men inte minst visar de att elementen i spänner upp hela vektorrummet .

Det tycker jag egentligen att man skulle kunna visa direkt, genom att utnyttja faktumet att varje -matris kan skrivas som summan av en symmetrisk och en skev-symmetrisk matris (vet du hur man visar detta?).

Men det de gör i lösningsförslaget är i stället att de utnyttjar ett litet trick, som ni säkert har gått igenom i kursen. Det gäller nämligen generellt för ett ändligt-dimensionella vektorrum att om man har en linjärt oberoende delmängd där antalet element är lika med , så måste vara en bas för (man behöver alltså inte kontrollera att verkligen spänner upp hela vektorrummet , utan det får man "på köpet" om antalet element i är korrekt).

I det här fallet är det ganska lätt att räkna sig fram till att antalet element i är (förstod du hur de kom fram till det?), och detta är precis lika med dimensionen för (är du med på varför dimensionen är just ?).

Slutsats: Mängden är en bas för bestående av egenvektorer, och avbildningen är alltså diagonaliserbar.

Bonusfråga: Hur ser matrisrepresentationen för ut med avseende på basen som vi just hittade (exempelvis för )?

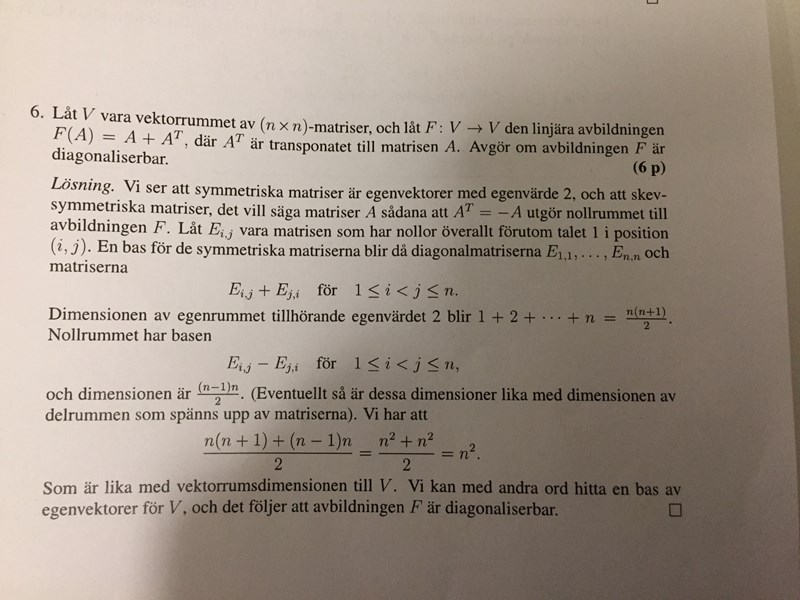

Tack för snabbt och utförligt svar! Jag förstår mer nu än innan. Jag har gått igenom det du skrivit några gånger nu och tror kanske jag förstår vad de menar med diagonaliserbar i det här fallet. Jag trodde man skulle visa att vektorerna (kolumnerna i matrisen ) kunde skrivas på formen PDP^-1, där P är matrisen med kolumner som innehåller egenvektorerna till och D diagonalmatrisen med respektive egenvärde. Bilden nedan är min tolkning av vad du har bevisat:

P är matrisen med egenvektorerna för avbildningen F (jag ser nu att jag skrev T(A) i bilden ovan men jag menade F(A)=P*D*P^-1), dvs basen ℬ. Har jag tolkat ditt bevis rätt i att man ska inte visa att vektorerna (kolumnerna i matrisen ) har linjärt oberoende egenvärden och därmed diagonaliserbar? Men eftersom det nu går att diagonalisera F som både du och facit påstår att det gör. Vad är i såna fall P^-1, dvs P i bilden ovan är uppenbarligen inte kvadratisk så hur hittar en inversen?

Jo, men du verkar vara (typ) helt rätt på det! Diagonaliseringen ger mycket riktigt en matris på den formen. Kan du visa hur den ser ut mer exakt om eller ?

Dock verkar du ha rört till det lite när det gäller den här matrisen . Det behövs nämligen ingen sådan i den här uppgiften. Anledningen är att det är viss skillnad på att diagonalisera en linjär avbildning, och att diagonalisera en matris.

Diagonalisering av en avbildning. Låt vara ett -dimensionellt vektorrum, och låt vara en linjär avbildning.

För varje val av en bas för , så kan vår linjära avbildning beskrivas med hjälp av en matris på följande vis:

där betecknar kolumnvektorn bestående av koordinaterna för vektorn med avseende på basen .

Om varje basvektor är en egenvektor, med , så kommer alla komponenter i kolumnvektorn att vara noll, förutom den i:te komponenten, som ju kommer att vara lika med . Det innebär att matrisen kommer vara en diagonalmatris, med egenvärdena på diagonalen, och vi säger att vi har diagonaliserat avbildningen .

Notera att ingen matris är inblandad i detta.

Diagonalisering av en matris. Låt . Vi kan tänka oss detta som en matrisrepresentation av en linjär avbildning med avseende på standardbasen för . Att diagonalisera innebär då att byta bas från standardbasen till en bas bestående av egenvektorer. När man har hittat en sådan bas kan vi bestämma diagonaliseringen genom att konjugera med hjälp av följande så kallade basbytesmatris:

där är vektorn uttryckt som en kolumnvektor, och när jag säger 'konjugera' menar jag alltså att formeln gäller, precis som vi är vana vid.

Sammanfattningsvis så är det alltså viss skillnad på att diagonalisera en linjär avbildning och diagonalisera en matris, även om det i båda fallen i grund och botten handlar om att hitta en bas av egenvektorer.

Skillnaden är att för matris så har man redan en matrisrepresentation för den bakomliggande avbildningen med avseende på en standardbas, och då handlar det om att byta bas, vilket man kan göra med hjälp av en basbytesmatris . För en abstrakt linjär avbildning har man normalt sett ingen standardbas alls att utgå från, och då makear det så klart inte sense att göra något basbyte.

Var detta begripligt? Annars är det så klart bara att säga till igen så försöker jag eller någon annan gärna förklara bättre!

I och för sig så kan vi så klart hitta på en standardbas för vårt vektorrum , ta fram en matrisrepresentation för med avseende på denna standardbas, och sedan diagonalisera denna matris med hjälp av en basbytesmatris precis som vanligt.

Detta vore faktiskt en bra övning att göra om du fortfarande känner att detta är lite förvirrande!

Jag föreslår att du som standardbas väljer (bestående av basvektorer).

Övertyga dig själv om att detta verkligen är en bas för , och bestämm matrisrepresentationen (detta kommer att vara en -matris). Diagonalisera sedan som du brukar diagonalisera matriser. Jämför resultatet med matrisrepresentationen som du fick fram i ditt förra inlägg genom att bestämma en bas av egenvektorer utan att gå omvägen via en standardbas!

För att det inte ska bli alltför stökigt rekommenderar jag att du väljer ett visst specifikt värde på , t.ex. (för vilket vi får ) eller .

oggih skrev:Jo, men du verkar vara (typ) helt rätt på det! Diagonaliseringen ger mycket riktigt en matris på den formen. Kan du visa hur den ser ut mer exakt om eller ?

Dock verkar du ha rört till det lite när det gäller den här matrisen . Det behövs nämligen ingen sådan i den här uppgiften. Anledningen är att det är viss skillnad på att diagonalisera en linjär avbildning, och att diagonalisera en matris.

Diagonalisering av en avbildning. Låt vara ett -dimensionellt vektorrum, och låt vara en linjär avbildning.

För varje val av en bas för , så kan vår linjära avbildning beskrivas med hjälp av en matris på följande vis:

där betecknar kolumnvektorn bestående av koordinaterna för vektorn med avseende på basen .

Om varje basvektor är en egenvektor, med , så kommer alla komponenter i kolumnvektorn att vara noll, förutom den i:te komponenten, som ju kommer att vara lika med . Det innebär att matrisen kommer vara en diagonalmatris, med egenvärdena på diagonalen, och vi säger att vi har diagonaliserat avbildningen .

Notera att ingen matris är inblandad i detta.

Diagonalisering av en matris. Låt . Vi kan tänka oss detta som en matrisrepresentation av en linjär avbildning med avseende på standardbasen för . Att diagonalisera innebär då att byta bas från standardbasen till en bas bestående av egenvektorer. När man har hittat en sådan bas kan vi bestämma diagonaliseringen genom att konjugera med hjälp av följande så kallade basbytesmatris:

där är vektorn uttryckt som en kolumnvektor, och när jag säger 'konjugera' menar jag alltså att formeln gäller, precis som vi är vana vid.

Sammanfattningsvis så är det alltså viss skillnad på att diagonalisera en linjär avbildning och diagonalisera en matris, även om det i båda fallen i grund och botten handlar om att hitta en bas av egenvektorer.

Skillnaden är att för matris så har man redan en matrisrepresentation för den bakomliggande avbildningen med avseende på en standardbas, och då handlar det om att byta bas, vilket man kan göra med hjälp av en basbytesmatris . För en abstrakt linjär avbildning har man normalt sett ingen standardbas alls att utgå från, och då makear det så klart inte sense att göra något basbyte.

Var detta begripligt? Annars är det så klart bara att säga till igen så försöker jag eller någon annan gärna förklara bättre!

Tack det klargjorde en hel del! Jag tänkte att diagonalisering av avbildning och av matris var samma vilket jag tydligt nu kan se att det inte är.

Dock är det fortfarande några frågor som kommer med nästa inlägg

oggih skrev:I och för sig så kan vi så klart hitta på en standardbas för vårt vektorrum , ta fram en matrisrepresentation för med avseende på denna standardbas, och sedan diagonalisera denna matris med hjälp av en basbytesmatris precis som vanligt.

Detta vore faktiskt en bra övning att göra om du fortfarande känner att detta är lite förvirrande!

Jag föreslår att du som standardbas väljer (bestående av basvektorer).

Övertyga dig själv om att detta verkligen är en bas för , och bestämm matrisrepresentationen (detta kommer att vara en -matris). Diagonalisera sedan som du brukar diagonalisera matriser. Jämför resultatet med matrisrepresentationen som du fick fram i ditt förra inlägg genom att bestämma en bas av egenvektorer utan att gå omvägen via en standardbas!

För att det inte ska bli alltför stökigt rekommenderar jag att du väljer ett visst specifikt värde på , t.ex. (för vilket vi får ) eller .

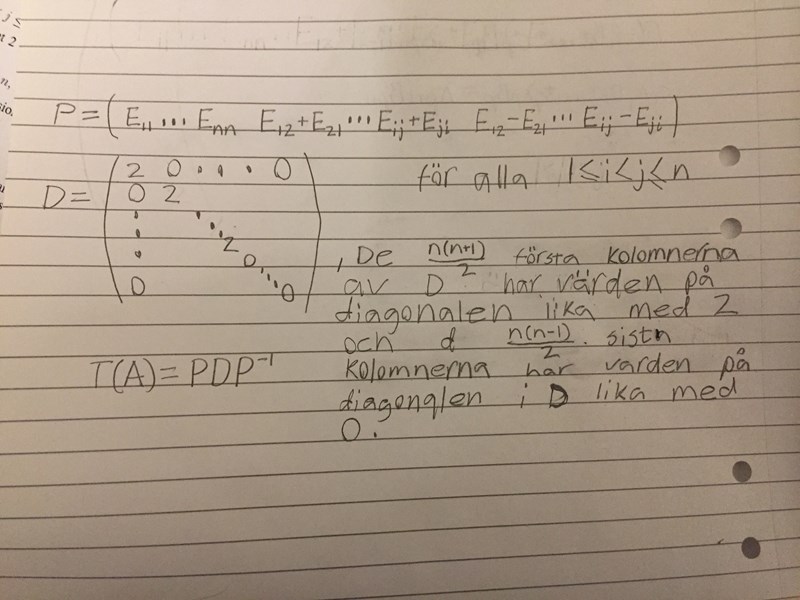

Mitt försök att bevisa att man kan använda standardbasen för att bevisa att matrisrepresentationen A = är diagonaliserbar är i bilden nedan:

Jag valde att försöka bevisa så allmänt jag kunde. Några frågor som uppkommer:

För det första så förstår jag inte multiplikationen mellan A och P.

För det andra förstår jag inte likheten i det sista uttrycket förutsatt att jag gjorde rätt ända fram till dess

För det tredje vad är raderna i A? Du påstår att A är (n^2)X(n^2), vilket jag tolkar som innebär att A har n^2 rader och n^2 kolumner.

Och återigen Tack!

Jag vidhåller att det är bra att göra detta för ett specifikt så att man verkligen konkret ser vad som händer. Låt oss därför sätta , så att . Vårt mål är nu som bekant att diagonalisera den linjära avbildningen som är definierad av .

Det enklaste sättet att göra detta är att direkt hitta en bas för vårt vektorrum , bestående av egenvektorer till . Det är detta vi gjorde i början av tråden. Med hjälp av resonemanget som vi förde där kommer vi fram till att är en "egenbas" för , där de tre första elementen har egenvärdet 2, och det sista elementet har egenvärdet 0, och det är därför uppenbart att matrisrepresentationen för med avseende på den här basen kommer att bli

Att hitta en sådan bas kräver dock ett visst mått av insikt eller att man gör en lyckosam gissning. I allmänhet när man stöter på en linjär avbildning är det lättare sagt än gjort att inse hur egenvektorerna kommer att se ut.

Om man inte lyckas hitta en bas för som som består av egenvektorer, kan man kanske i stället försöka hitta en "vanlig" bas för i stället, hitta en matrisrepresentation med avseende på den basen, och sedan diagonalisera den här matrisen på vanligt vis (med hjälp av en basbytesmatris).

Här är ett naturligt val av bas för .

Vi ser att och att . På liknande sätt kommer vi fram till att och att .

Matrisrepresentationen för med avseende på blir därför

Vi diagonaliserar nu denna matris på det vanliga sättet man lär sig i en första kurs i linjär algebra. Det karaktäristiska polynomet blir , och har rötterna 2 [med multiplicitet 3] och 0 [med multiplicitet 1]. Detta innebär att har egenvärdena 2 och 0 (och inga andra egenvärden), precis som vi kom fram till i början av tråden.

Vi vill nu hitta en bas för bestående av egenvektorer till , vilket motsvarar att hitta tre linjärt oberoende vektorer i nollrummet till samt en nollskild vektor ur nollrummet till matrisen . Med lite Gauss-elimination får jag fram vektorerna

Tillsammans bildar de en ny bas för , och den motsvarande basbytesmatrisen blir

När vi genomför basbytet till den nya basen (genom att konjugera med ) får vi

dvs. precis samma resultat som ovan! ^_^

Hänger du med på alla steg i det här inlägget? Detta med matrisrepresentationer, basbyten och diagonalisering är svårt men väldigt viktigt, så om något känns oklart så är det bra om du säger till.

oggih skrev:Jag vidhåller att det är bra att göra detta för ett specifikt så att man verkligen konkret ser vad som händer. Låt oss därför sätta , så att . Vårt mål är nu som bekant att diagonalisera den linjära avbildningen som är definierad av .

Det enklaste sättet att göra detta är att direkt hitta en bas för vårt vektorrum , bestående av egenvektorer till . Det är detta vi gjorde i början av tråden. Med hjälp av resonemanget som vi förde där kommer vi fram till att är en "egenbas" för , där de tre första elementen har egenvärdet 2, och det sista elementet har egenvärdet 0, och det är därför uppenbart att matrisrepresentationen för med avseende på den här basen kommer att bli

Att hitta en sådan bas kräver dock ett visst mått av insikt eller att man gör en lyckosam gissning. I allmänhet när man stöter på en linjär avbildning är det lättare sagt än gjort att inse hur egenvektorerna kommer att se ut.

Om man inte lyckas hitta en bas för som som består av egenvektorer, kan man kanske i stället försöka hitta en "vanlig" bas för i stället, hitta en matrisrepresentation med avseende på den basen, och sedan diagonalisera den här matrisen på vanligt vis (med hjälp av en basbytesmatris).

Här är ett naturligt val av bas för .

Vi ser att och att . På liknande sätt kommer vi fram till att och att .

Matrisrepresentationen för med avseende på blir därför

Vi diagonaliserar nu denna matris på det vanliga sättet man lär sig i en första kurs i linjär algebra. Det karaktäristiska polynomet blir , och har rötterna 2 [med multiplicitet 3] och 0 [med multiplicitet 1]. Detta innebär att har egenvärdena 2 och 0 (och inga andra egenvärden), precis som vi kom fram till i början av tråden.

Vi vill nu hitta en bas för bestående av egenvektorer till , vilket motsvarar att hitta tre linjärt oberoende vektorer i nollrummet till samt en nollskild vektor ur nollrummet till matrisen . Med lite Gauss-elimination får jag fram vektorerna

Tillsammans bildar de en ny bas för , och den motsvarande basbytesmatrisen blir

När vi genomför basbytet till den nya basen (genom att konjugera med ) får vi

dvs. precis samma resultat som ovan! ^_^

Hänger du med på alla steg i det här inlägget? Detta med matrisrepresentationer, basbyten och diagonalisering är svårt men väldigt viktigt, så om något känns oklart så är det bra om du säger till.

Tack oggih du är en hjälte! Jag tänkte inte på att en matris i V kunde representeras som en kolumnvektor. Sen tar du bara basvektorn till denna och sätter in i F för att få ut transformationsmatrisen.

Om du vill kontrollera din förståelse så skulle du kunna upprepa det som vi just gjorde för ett annat värde på , säg . Det kommer bli en del att skriva (-matriser...), men det kan nog vara värt jobbet! ^_^