Varför används inte LLMs på Pluggakuten?

Varför inte används LLMs på Pluggakuten? Det skulle ju effektivisera hela flödet samt hjälpen som man kan få, och det finns ju en hel del träningsdata att träna modellen på.

Du menar att frågorna man ställer besvaras av ett program istället för användare? Eller att flödet ska sorteras med AI?

Med det förstnämnda skulle ju allt det fina och bra med PA försvinna. Vill man att en AI ska hjälpa en med läxorna kan man istället använda Chatgpt.

Vad är LLM?

Jag antar att drt är Large Language Model som avses.

För att det finns riktiga människor här som kan förstå och hjälpa på ett sätt som en AI inte kan.

Jag tycker att frågeställningen kan vara intressant, lite beroende på vad man är ute efter.

@Farbrorgul, var det något speciellt du tänkte på, alltså på vilket/vilka sätt LLM skulle kunna användas?

Mrpotatohead skrev:Du menar att frågorna man ställer besvaras av ett program istället för användare? Eller att flödet ska sorteras med AI?

Med det förstnämnda skulle ju allt det fina och bra med PA försvinna. Vill man att en AI ska hjälpa en med läxorna kan man istället använda Chatgpt.

Det finns många sätt att använda LLM för. Ett exempel är ju att ge förslag på trådar som kanske redan tagit upp ämnet/frågan som frågas om. Ett annat är att generera svaret på frågan som det gäller.

Smaragdalena skrev:För att det finns riktiga människor här som kan förstå och hjälpa på ett sätt som en AI inte kan.

Hur menar du här? Om modellen tränas på alla Pluggakutens svar borde den väl kunna hjälpa till bättre än det genomsnittliga svaret?

Yngve skrev:Jag tycker att frågeställningen kan vara intressant, lite beroende på vad man är ute efter.

@Farbrorgul, var det något speciellt du tänkte på, alltså på vilket/vilka sätt LLM skulle kunna användas?

Förklara saker på ett väldigt pedagogiskt sätt (automatiskt anpassat på nivån), förslag på liknande trådar/frågor där frågeställaren varit nöjd med hjälpen, hjälp med att formulera frågorna bättre, osv. Finns egentligen hur många saker som helst som kan förbättras med LLMs.

Laguna skrev:Vad är LLM?

LLM står för "Large Language Models" och är avancerade AI-modeller som är tränade på stora mängder textdata för att förstå och generera mänskligt liknande text. Dessa modeller använder maskininlärningstekniker, såsom neurala nätverk, för att förutsäga nästa ord eller fras baserat på tidigare textkontext. Exempel på LLM inkluderar GPT (Generative Pre-trained Transformer)-modellerna, där GPT-3 är ett exempel på en sådan modell. Dessa modeller har olika tillämpningar, inklusive textgenerering, översättning, frågesvar och mer.

En AI kan inte tänka, bara producera text som ser ut som svar.

Leta fram tidigare trådar som handlar om samma sak skulle vara en bra funktion.

Att handleda en elev genom en lång tråd av frågor och svar är nog inte så lätt. Fall där man ger ett perfekt svar så att eleven är nöjd direkt kan säkert förekomma. Ofta får nog en människa ingripa och inte bara ta hand om elevens fråga utan också reda ut förvirringen som det första svaret skapade.

Smaragdalena skrev:En AI kan inte tänka, bara producera text som ser ut som svar.

I detta fall är ju detta ett forum kallat Pluggakuten, där mer eller mindre liknande frågor besvaras varje dag. Det är inte en forskargrupp som ska innovera och tänka helt utanför ramarna. Om modellen är tränad på uppgifter kommer den kunna hjälpa till på precis samma sätt (troligtvis bättre). Dessutom är frågorna ofta på ganska grundläggande nivå och det finns modeller som är tränade för att lösa t.ex. matematiska problem. Jag tycker att du har en väldigt defensiv strategi, jag trodde ny teknik och proaktivitet var något som matematiker och fysiker älskar.

Jag är nyfiken och absolut intresserad av en diskussion kring olika typer av nyttoeffekter som detta skulle kunna medföra.

Jag tycker bland annat att det vore utmärkt med en möjlighet att kunna dra nytta av det stora textmaterial som finns tillgängligt i form av hundratusentals (?) tidigare trådar.

Det är ju omöjligt för en människa att omfamna allt detta och den sökfunktion som finns tillgänglig lämnar ju ärligt talat mycket övrigt att önska.

Mycket vore vunnet om det gick att förbättra den, och/eller att få förslag på tidigare trådar med liknande frågeställningar.

Det finns säkert massor med andra funktioner som kan vara intressanta.

Jag misstänker dock att en stor utmaning här är den ekonomiska aspekten.

Budgeten för PA är väldigt begränsad och har under årens lopp hela tiden varit den stora bromsklossen vad gäller förnyelse.

Yngve skrev:Jag är nyfiken och absolut intresserad av en diskussion kring olika typer av nyttoeffekter som detta skulle kunna medföra.

Jag tycker bland annat att det vore utmärkt med en möjlighet att kunna dra nytta av det stora textmaterial som finns tillgängligt i form av hundratusentals (?) tidigare trådar.

Det är ju omöjligt för en människa att omfamna allt detta och den sökfunktion som finns tillgänglig lämnar ju ärligt talat mycket övrigt att önska.

Mycket vore vunnet om det gick att förbättra den, och/eller att få förslag på tidigare trådar med liknande frågeställningar.

Det finns säkert massor med andra funktioner som kan vara intressanta.

Jag misstänker dock att en stor utmaning här är den ekonomiska aspekten.

Budgeten för PA är väldigt begränsad och har under årens lopp hela tiden varit den stora bromsklossen vad gäller förnyelse.

Att träna en modell på hundratusentals datapunkter är inget som kostar särskilt mycket idag. Det kan göras lokalt på en Macbook med M-chip, eller ännu hellre med ett GPU, på ett par timmar. Jag hade gärna hjälpt till med att bygga denna funktion på forumet.

Finns några olika anledningar till att det inte finns:

- Pluggakuten är nästan 20 år gammalt, när det skapades var det av naturliga skäl inte aktuellt. Sedan dess har forumet visserligen utvecklats men det har mest handlat om att byta ”kostym” snarare än funktionalitet.

- Det kostar antagligen en del pengar. Mattecentrum som driver sidan badar inte i sådant.

- Det har inte efterfrågats tillräckligt mycket för att det ska ha varit en prioriterad fråga att driva.

Om du har utvecklingsförslag av mer avancerad karaktär är det nog nästan bäst att direkt kontakta Mattecentrums kansli via pluggakuten@mattecentrum.se

LLM och liknande AI-verktyg är en del av framtiden och det finns säkert en användning för dem även på Pluggakuten.

Däremot tror jag att det är viktigt att Pluggakuten behåller sin USP(Unique Selling point) som är den mänskliga interaktionen, att det är en människa och inte en maskin som svarar dig. Jag har ibland funderat på varför studenter fortfarande använder Plugggakuten när man kan få ett många gånger snabbare och mer utförligt svar genom att fråga en AI-bot, som också är helt gratis. Det enda jag kan komma fram till är att dels den mänskliga interaktionen är viktig, att du kommunicerar med en verklig person samt att en person har en större trovärdighet och också kan ge mer kvalitativ hjälp. Pluggakuten kommer aldrig kunna konkurrera med dessa AI-verktyg på deras arena.

Däremot exempelvis effektiva trådsökningsfunktioner är ett konkret användningsområde där jag tror AI kan göra nytta, där man kan när man skriver en fråga, kan få upp förslag på liknande trådar som skulle kunna hjälpa en. Det skulle stärka Pluggakuten som kunskapsbank, vilket är ännu en fördel den har gentemot ex. Chat GPT där användarens frågor och svar inte finns sparat för andra att använda sig av.

Farbrorgul skrev:Laguna skrev:Vad är LLM?

LLM står för "Large Language Models" och är avancerade AI-modeller som är tränade på stora mängder textdata för att förstå och generera mänskligt liknande text. Dessa modeller använder maskininlärningstekniker, såsom neurala nätverk, för att förutsäga nästa ord eller fras baserat på tidigare textkontext. Exempel på LLM inkluderar GPT (Generative Pre-trained Transformer)-modellerna, där GPT-3 är ett exempel på en sådan modell. Dessa modeller har olika tillämpningar, inklusive textgenerering, översättning, frågesvar och mer.

Bara av ren nyfikenhet, är detta svar skrivet av en LLM? :)

Hondel skrev:Farbrorgul skrev:Laguna skrev:Vad är LLM?

LLM står för "Large Language Models" och är avancerade AI-modeller som är tränade på stora mängder textdata för att förstå och generera mänskligt liknande text. Dessa modeller använder maskininlärningstekniker, såsom neurala nätverk, för att förutsäga nästa ord eller fras baserat på tidigare textkontext. Exempel på LLM inkluderar GPT (Generative Pre-trained Transformer)-modellerna, där GPT-3 är ett exempel på en sådan modell. Dessa modeller har olika tillämpningar, inklusive textgenerering, översättning, frågesvar och mer.

Bara av ren nyfikenhet, är detta svar skrivet av en LLM? :)

Haha ja, jag kunde inte låta bli att svara på frågan om LLM genom en LLM.

Jonto skrev:LLM och liknande AI-verktyg är en del av framtiden och det finns säkert en användning för dem även på Pluggakuten.

Däremot tror jag att det är viktigt att Pluggakuten behåller sin USP(Unique Selling point) som är den mänskliga interaktionen, att det är en människa och inte en maskin som svarar dig. Jag har ibland funderat på varför studenter fortfarande använder Plugggakuten när man kan få ett många gånger snabbare och mer utförligt svar genom att fråga en AI-bot, som också är helt gratis. Det enda jag kan komma fram till är att dels den mänskliga interaktionen är viktig, att du kommunicerar med en verklig person samt att en person har en större trovärdighet och också kan ge mer kvalitativ hjälp. Pluggakuten kommer aldrig kunna konkurrera med dessa AI-verktyg på deras arena.

Däremot exempelvis effektiva trådsökningsfunktioner är ett konkret användningsområde där jag tror AI kan göra nytta, där man kan när man skriver en fråga, kan få upp förslag på liknande trådar som skulle kunna hjälpa en. Det skulle stärka Pluggakuten som kunskapsbank, vilket är ännu en fördel den har gentemot ex. Chat GPT där användarens frågor och svar inte finns sparat för andra att använda sig av.

Jag ser det inte som att konkurrera med chattbottar utan att komplettera med dem. Precis som du säger kan det användas på andra sätt än att generera text. Man kan t.ex. korrigera dåligt formulerade frågor eller svar, ge förslag på liknande trådar/frågor, prompta "förklara detta svar för mig som om jag vore tio år", klassificera frågor, m.m.

Det här är bra komplement, men jag har fått hjälp här i vissa grejer som AI inte kan hjälpa med (ex. ssembler programmering och C++).

Det hade nog varit användbart för gymnasie-matematik/fysik tror jag.

Farbrorgul skrev:Yngve skrev:Jag är nyfiken och absolut intresserad av en diskussion kring olika typer av nyttoeffekter som detta skulle kunna medföra.

Jag tycker bland annat att det vore utmärkt med en möjlighet att kunna dra nytta av det stora textmaterial som finns tillgängligt i form av hundratusentals (?) tidigare trådar.

Det är ju omöjligt för en människa att omfamna allt detta och den sökfunktion som finns tillgänglig lämnar ju ärligt talat mycket övrigt att önska.

Mycket vore vunnet om det gick att förbättra den, och/eller att få förslag på tidigare trådar med liknande frågeställningar.

Det finns säkert massor med andra funktioner som kan vara intressanta.

Jag misstänker dock att en stor utmaning här är den ekonomiska aspekten.

Budgeten för PA är väldigt begränsad och har under årens lopp hela tiden varit den stora bromsklossen vad gäller förnyelse.

Att träna en modell på hundratusentals datapunkter är inget som kostar särskilt mycket idag. Det kan göras lokalt på en Macbook med M-chip, eller ännu hellre med ett GPU, på ett par timmar. Jag hade gärna hjälpt till med att bygga denna funktion på forumet.

Men efter den har tränats ska den användas också, och driften är inte heller gratis. Men det är klart, jag vet inte hur mycket den kostanden är jämfört med övriga kostnader för drift.

Farbrorgul skrev:Hondel skrev:Farbrorgul skrev:Laguna skrev:Vad är LLM?

LLM står för "Large Language Models" och är avancerade AI-modeller som är tränade på stora mängder textdata för att förstå och generera mänskligt liknande text. Dessa modeller använder maskininlärningstekniker, såsom neurala nätverk, för att förutsäga nästa ord eller fras baserat på tidigare textkontext. Exempel på LLM inkluderar GPT (Generative Pre-trained Transformer)-modellerna, där GPT-3 är ett exempel på en sådan modell. Dessa modeller har olika tillämpningar, inklusive textgenerering, översättning, frågesvar och mer.

Bara av ren nyfikenhet, är detta svar skrivet av en LLM? :)

Haha ja, jag kunde inte låta bli att svara på frågan om LLM genom en LLM.

Mhm, jag tyckte det lät lite som chatGPT, eller var det annat du använde? För min erfarenhet är att chatGPT har druckit surrolja. Jag menar, om du inte vet vad LLM är för något räcker första meningen för att du ska förstå. Resten är ju bara förvirrande. Det är inte fel i sak, men det är, i mitt tycke, ganska intetsägande för någon utan förkunskaper.

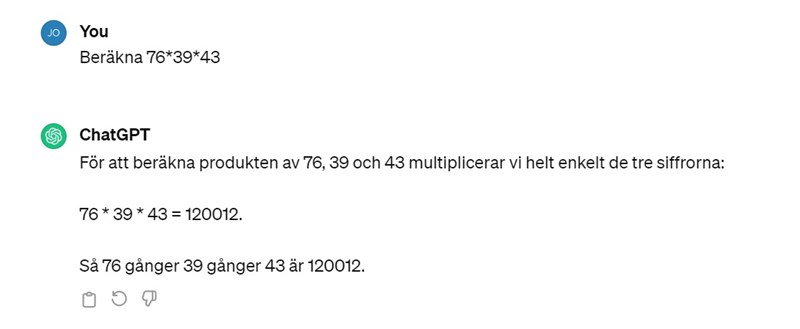

Här är ett exempel på varför jag tycker PA skall hålla sig långt borta från chatGPT. chatGPT har helt enkelt fel.

AI har ofta fel, ja.

Detta är för att AI arbetar efter att ge svar som för oss verkar trovärdiga och har lärts upp av data som kommer från människor. Den genererar alltså inte primärt information som är så korrekt som möjlig, utan information som ska verka korrekt.

Ett exempel är att den är urusel på matematik. Du kan ibland ge AI en beräkning se nedan 76 * 39 *43 och den svarar tvärsäkert 12 0012. Detta svaret kommer för en människa upplevas som trovärdigt för att det ligger någorlunda nära och vi inte direkt kan se att det är fel. En miniräknare från 1950-talet (eller ja vilken fungerande miniräknare som helst) hade dock löst uppgiften mycket bättre och kunnat få fram det korrekta svaret 127 452.

Nu kanske jag rör mig ifrån temat på tråden lite men...

Det här blir en enorm svaghet när elever tror att ChatGPT är en form av kunskapsbank och använder den som sådan. ChatGPT och andra AI kan ge bra idéer, uppslag eller underlättnader men det behöver finnas en människa som kan kontrollera och sortera informationen.

Sen till tråden, men det är en intressant fråga.

När det gäller svar håller jag med de ovanstående talare som uttrycker tveksamhet. Man måste komma ihåg att språkmodeller är tränade på att uttrycka språkligt korrekta svar, inte faktamässigt korrekta svar. Träningsmaterialet för ChatGPT är tränad på mänskligt material, som många gånger är korrekt, men definitivt inte alltid. Frågorna på Pluggakuten är vitt skilda, och träningsmaterialet är inte så stort (140k trådar och cirka 130k på gamla Pluggakuten).

Den andra frågan är väl, om nu ChatGPT eller liknande skulle användas på Pluggakuten, varför inte bara använda dagens ChatGPT? Varför uppfinna hjulet igen? :)

Med det sagt, kanske det skulle kunna finnas andra användningsområden för maskininlärning på Pluggakuten. Exempelvis kanske det vore en möjlighet att använda maskininlärning för att hitta trådar som liknar den som trådstartaren frågar om. När trådstartaren anger sin fråga, rekommenderas upp till tre trådar som innehåller (nästan) samma fråga. Även om 270 tusen trådar inte är så mycket till träningsdata, är det mycket för att vara en kunskapsbas.

Det pratas ibland om olika sätt att utnyttja den resursen bättre, bland annat genom en bättre sökfunktion (Pluggakutens sökfunktion idag är rätt dålig, tyvärr). Samtidigt är det svårt att göra en bättre sökfunktion än den google hade 2022-2023. Men å andra sidan är ingen sökfunktion särskilt bra om den inte används, vilket är rätt vanligt på Pluggakuten (med reservation för att vi inte ser de som söker och hittar vad de behöver, och aldrig postar tråden).

Kanske skulle det kunna vara värdefullt att utveckla en funktion som samlar ihop trådar inom ett ämne och en svårighetsgrad, för att ta fram exempelvis för användare som vill ha många uppgifter att träna på inför ett prov?

Oavsett, intressant fråga, och det kan nog finnas många användningsområden för maskininlärning på Pluggakuten, även om jag inte tror att automatisering av hela svarsprocessen är rätt väg att gå, åtminstone just nu. :)

Jonto skrev:AI har ofta fel, ja.

Beror helt på vilken modell du använder.

Ett exempel är att den är urusel på matematik.

Beror helt på vilken modell du använder.

Du kan ibland ge AI en beräkning se nedan 76 * 39 *43 och den svarar tvärsäkert 12 0012.

Beror helt på vilken modell du använder.

Det där du visar bild på är ChatGPT-3.5, ökänt dålig på matematik. Farbrorgul sa inte "implementera ChatGPT-3.5 på Pluggakuten". Som han sa:

Jag tycker att du har en väldigt defensiv strategi, jag trodde ny teknik och proaktivitet var något som matematiker och fysiker älskar.

Maskininlärning och AI är vida begrepp, gratisversionen för ChatGPT är väldigt snäv - likställ dem inte.

Notera att det finns ganska mycket forskning på modeller specifikt tränade på matematiska problem med en träffsäkerhet långt över vilken människa som helst.

Sedan allt detta prat om budget. Farbrorgul skrev till och med att denne skulle kunna arbeta ideellt med implementeringen. Tsk tsk tsk.

SaintVenant skrev:Maskininlärning och AI är vida begrepp, gratisversionen för ChatGPT är väldigt snäv - likställ dem inte.

Notera att det finns ganska mycket forskning på modeller specifikt tränade på matematiska problem med en träffsäkerhet långt över vilken människa som helst.

Det stämmer, frågan är snarare om vi vill att Pluggakuten ska gå i den riktningen. Själv är jag tveksam, men det är absolut en diskussion värd att ha, så detta är en bra tråd. Med tanke på hur många andra AI-verktyg det finns, är det värt att fundera på om Pluggakuten ska försöka implementera ett.

Redan idag går det ju alldeles utmärkt att använda WolframAlpha för att få riktigt bra svar på de flesta matematikfrågor, på en bråkdel av tiden det tar att ens skriva ett inlägg på Pluggakuten. Nog för att ChatGPT 3.5 är ganska nytt, men WolframAlpha har funnits rätt länge. Ändå söker sig användare till Pluggakuten. Det kan såklart finnas jättemånga olika förklaringar till det, men en kan nog vara den mänskliga aspekten. Men det kan absolut vara värt att fundera på varför det ställs på många frågor på Pluggakuten, trots att det finns så många andra sätt att få svar på sina frågor.

Sedan allt detta prat om budget. Farbrorgul skrev till och med att denne skulle kunna arbeta ideellt med implementeringen. Tsk tsk tsk.

Budget är en relevant fråga, även om Farbrorgul eller andra arbetar ideellt med implementeringen. Dels driftkostnaderna, men framförallt kan vi vänta oss att Mattecentrum kommer att kräva att webbyrån ska gå igenom och testa allt innan det implementeras, så även om ideellt arbete säkert skulle minska kostnaderna, är det fortfarande inte en oansenlig kostnad. Som sagt, det lär absolut inte vara omöjligt att få till, men det är fortfarande relevant att väga förslaget mot de andra förslag som finns.

Smutstvätt skrev:Ändå söker sig användare till Pluggakuten. Det kan såklart finnas jättemånga olika förklaringar till det, men en kan nog vara den mänskliga aspekten. Men det kan absolut vara värt att fundera på varför det ställs på många frågor på Pluggakuten, trots att det finns så många andra sätt att få svar på sina frågor.

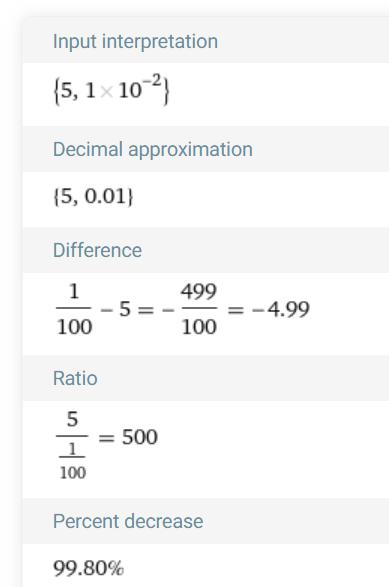

En förklaring är att jag med det jag har innanför skallbenet kan tolka vad som ofta är en felvänd oskarp bild tagen med mobilkamera av mattebok i dålig belysning.

Det erbjuder inte WolframAlpha idag och för att kunna använda detta kraftfulla verktyg behöver du ändå kunna formulera ditt problem. Min erfarenhet är att den som frågar inte ens vet var den skall börja.

En annan sak jag fixar är att ofta gissar rätt. Jag kan förstå av sammanhanget att det står här: 5,1*10-2. Dessutom kan jag vänligen påpeka misstaget så att personen inte fortsätter göra samma fel, exempelvis i WA.

För övrigt skulle WA inte tolka kommatecknet som decimaltecken, utan det skulle gå utför rätt snabbt:

Den mänskliga aspekten, som sagt, från en som arbetar med AI-stödd systemutveckling och språkmodeller.