Varför påstår folk fortfarande att AI skulle vara dålig på matte och fysik?

Okej, i matten kan den väl vara lite svajig i vissa områden men annars så hade GPT enkelt kunnat få nästintill maxpoäng i samtliga kurser jag läst nu på universitet exkl labbarna ;) (teknisk fysik, Chalmers). Jag är medveten om att det fortfarande är grundläggande nivå men man kan ju inte bli annat än imponerad när man kan skärmklippa i princip vilken uppgift som helst (skräddarsydda av vår examinator som bland annat skriver frågor till MaFy) i stelkroppsmekanik + anaytisk mekanik + specrel och den spottar ut korrekta och välgjorda lösningar. Att man sedan kan ställa oändligt med följdfrågor är också sjukt. Det finns inga ursäkter för studenter längre! (säger jag efter jag nästan kuggade dagens mekaniktenta... hehe)

Vad känner ni? Jag tycker spontant att jag ser alldeles för mycket "höhö, GPT kan inte ens räkna 3+3" när den uppenbarligen är sanslöst bra. Ni som löser lite svårare problem får gärna berätta hur bra den är på dem.

Allt gott,

MrP

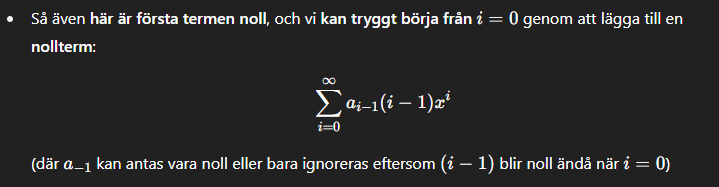

GPT4.1 senast idag:

Blamear alltid promptaren! ;) Nää, men viss matte är den ingen höjdare på. Svårast för den hittills var nog just vår fortsättningsanalys som var mycket serier, följder, likf konv osv.

Självklart är det ett kraftfullt hjälpmedel, men man måste vara medveten om dess svagheter. En vanlig fälla är att den låter väldigt trygg och säker på sin sak, även när den hallucinerar.

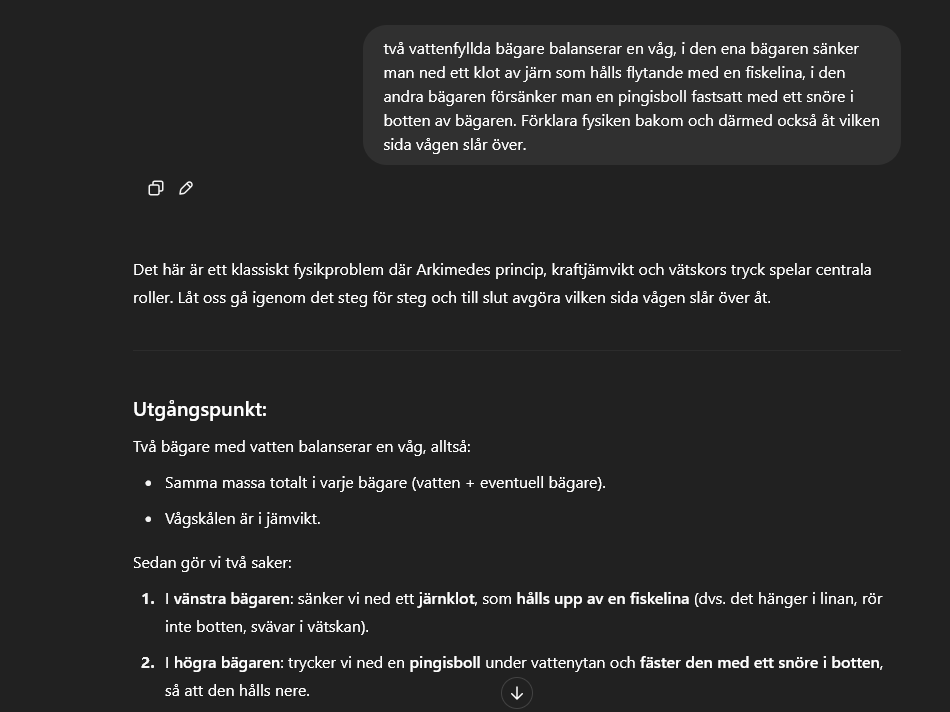

Den är duktig på "typtal", men så fort svaret kräver att man kombinerar olika domäner eller när träningsdata är bristfällig (dvs när svaret inte går att finna på math.stackexchange eller physicsforums/physics.stackexchange) brukar det kärva rejält. Andra exempel där AI alltid får svårt att hävda sig är när man ställer "öppna" frågor, exempel:

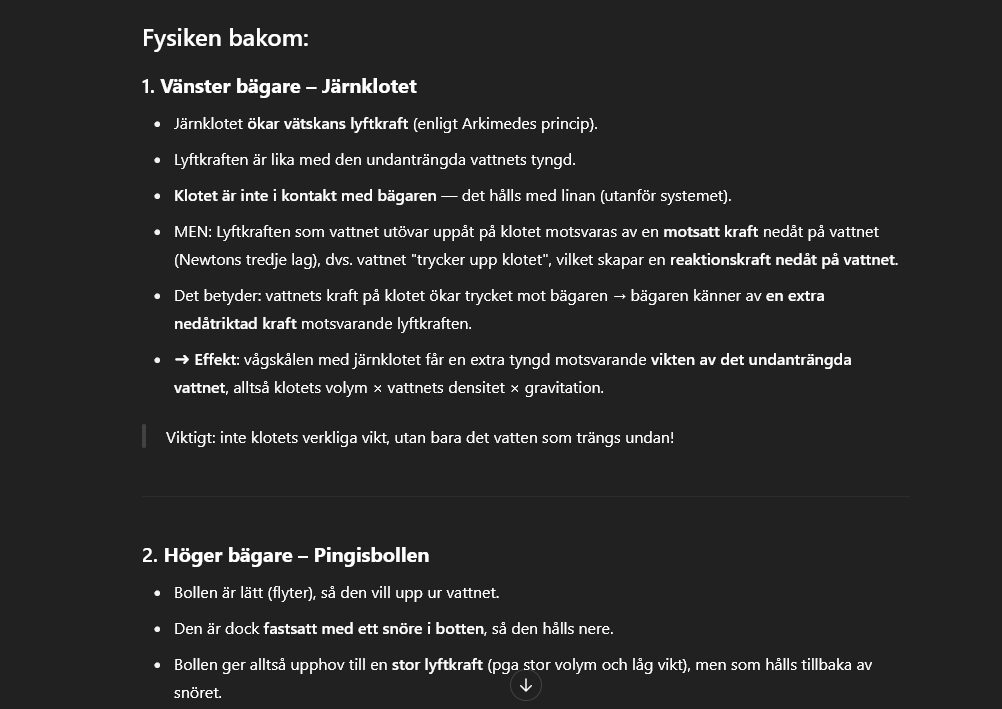

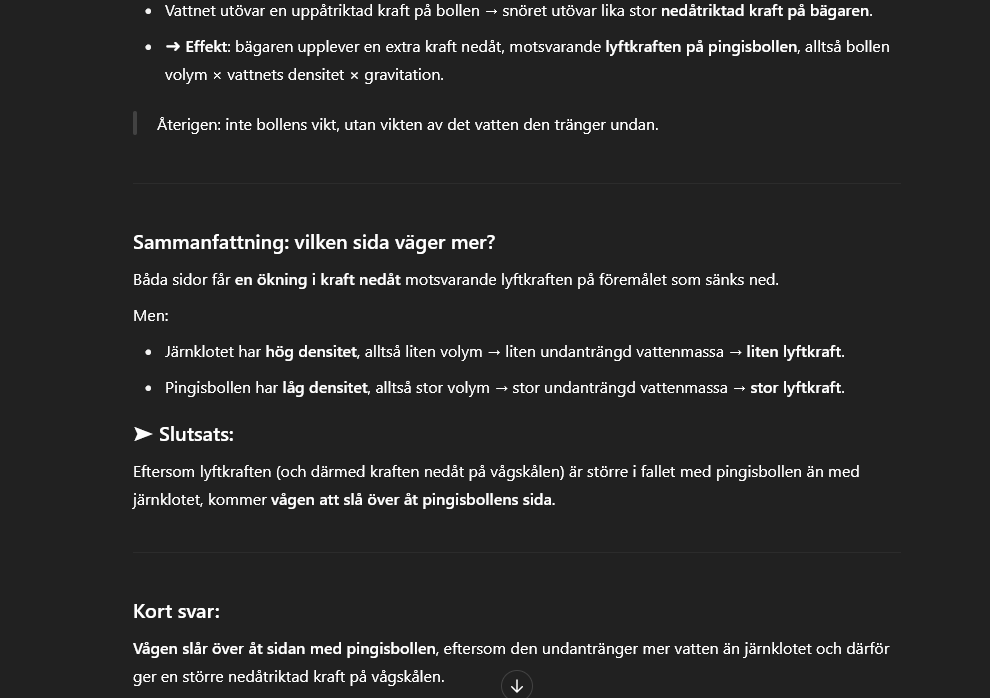

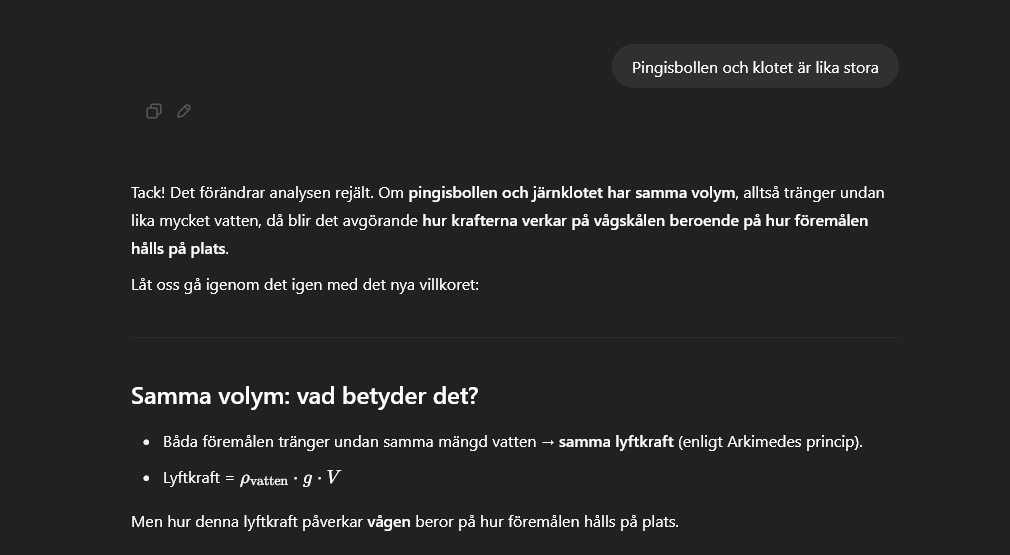

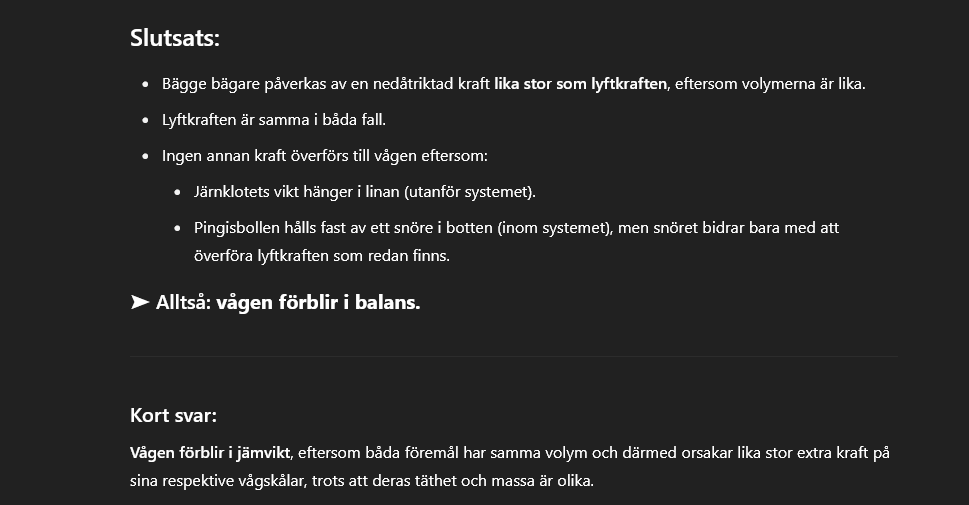

ChatGPT känner alltså till problemet och resonerar och spekulerar på det sätt man typiskt ser studenter göra i de flesta trådar på nätet som handlar om problemet. Sedan landar den i fel slutsats. Vi försöker hjälpa den lite på vägen...

Och efter lite ytterligare analys och hallucinationer kommer den fram till att

Återigen gissar den fel; denna gång med en förklaring om "lika stor extra kraft. Youtubevideo om problemet:

Enligt min erfarenhet klarar den sällan att lösa matematiska problem som inte är rutinuppgifter jag ger den, och gör väldigt underliga misstag. Exempelvis har den dragit slutsatser som "våra ekvationer har för många okända, så vi testar att byta variabelnamn", eller "funktionen är växande på nästan hela intervallet, så därför är den växande på hela intervallet."

För programmering tycker jag det kan vara mer användbart, men då mest som för att påbörja saker eller skriva "boilerplate"-kod, eller för auto-complete i editorn. Det blir sällan någon bra arkitektur som går att skala och leder ofta till att man behöver skriva om allt om man vill jobba vidare.

Jag har inte heller fått så jättebra intryck av när jag försökt leta upp forskning inom olika områden.

Ibland använder jag den genom att be den lösa något och sedan verifiera lösningen. Ibland är det lättare att verifiera och eventuellt rätta till något redan existerande snarare än att börja själv.

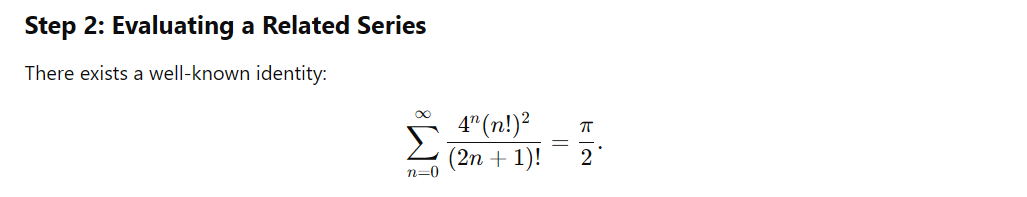

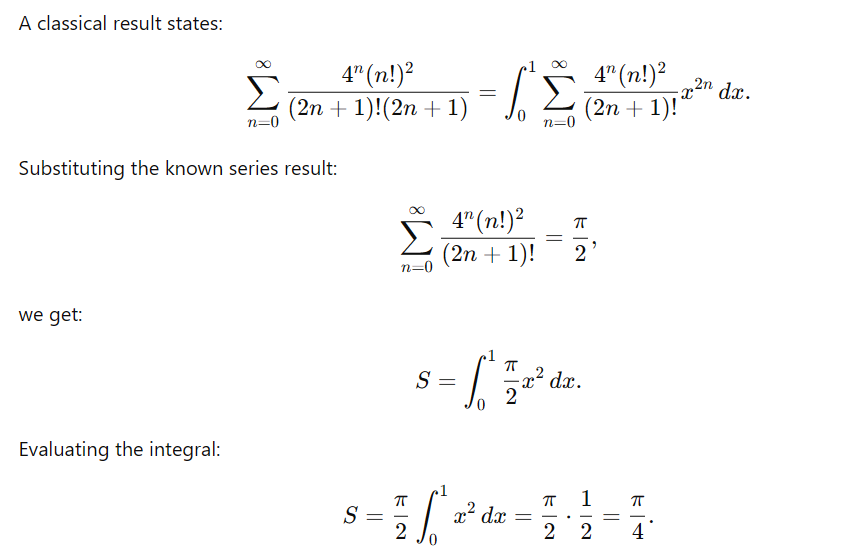

Jag har testat LLMs lite grann med just mitt favoritområde, integraler och summor. När jag ger chatgpt några summor och integraler som är välkända (Gauss' integral, Fresnelintegralerna, osv) kan den ge de vanliga lösningarna. Om jag däremot ger integraler eller summor som är ungefär lika svåra som jag själv har skapat, får den helt fel. Ett exempel är när jag gav den

Denna summa är inte jättelätt att beräkna och jag förväntar mig inte alls att LLMs ska kunna lösa något sådant här. Problemet är om man genuint skulle be den om hjälp att lösa denna. Det finns så många fel. De flesta stegen ser ut som att den försöker kopiera en klassisk härledning, där man använder någon sats för att lösa problemet: och sedan försöker den använda denna "identitet" (som är inte stämmer eftersom den summan är divergent) för att beräkna summan. Den gör detta på ett mycket felaktigt sätt:

och sedan försöker den använda denna "identitet" (som är inte stämmer eftersom den summan är divergent) för att beräkna summan. Den gör detta på ett mycket felaktigt sätt:

Om man kikar på varje steg förutom det första finns det något fel.

Jag tror det största problemet är att den alltid ger ett svar och det kan låta halvt övertygande. I mitt exempel är det rätt lätt att se felen i dess beräkningar, men i vissa fall kan det vara svårare. Särskilt om man ber en LLM om hjälp.

För programmering tycker jag det kan vara mer användbart, men då mest som för att påbörja saker eller skriva "boilerplate"-kod, eller för auto-complete i editorn. Det blir sällan någon bra arkitektur som går att skala och leder ofta till att man behöver skriva om allt om man vill jobba vidare.

Medhåll till 100 % på detta. Det enda jag tycker GPT (och liknande LLMS) är någorlunda användbara för är att skriva boilerplates och annan repetetiv kod jag inte pallar skriva själv

Okej, tack för flera svar. Man behöver självklart ha sunt förnuft när man använder AI. Det krävs att man delvis kan verifiera svar och att man använder den på ett sätt man är ganska säker på att den kommer kunna ge ett bra svar.

Angående majoriteten av mina kurser kan man säga att jag hittills inte läst något tillräckligt avancerat, som för en AI mäts i hur "välkänt" det är. Svårigheten ligger snarare i att på en begränsad tid nå en "bra förståelse" inom ett väldigt stort område. Men den insikten är jag nog inte först i världen med att få om ett ingenjörsprogram.